JUC

1. 进程与线程

1.1 进程与线程

进程是系统进行资源分配和保护的基本单位,线程是处理器调度和分配的基本单位

进程

- 进程是操作系统进行资源分配和保护的基本单位,它是程序的一次执行过程,拥有独立的内存空间和系统资源。每个进程都运行在独立的虚拟地址空间中,一个进程崩溃通常不会影响其他进程的运行。

线程

-

线程有时也被称为轻量级的进程

-

一个线程就是一个指令流,将指令流中的一条条指令以一定的顺序交给 CPU 执行

-

一个进程可以包含多个线程,这些线程共享进程的资源

-

在 windows 中进程是不活动的,只是作为线程的容器

线程进程对比

-

进程基本上相互独立,而线程存在于进程内,是进程的一个子集

-

进程拥有共享的资源,如内存空间等,供其内部的线程共享

-

进程间通信较为复杂

同一台计算机的进程通信称为 IPC(Inter-process communication)

- 信号量:信号量是一个计数器,用于多进程对共享数据的访问,解决同步相关的问题并避免竞争条件

- 共享存储:多个进程可以访问同一块内存空间,需要使用信号量用来同步对共享存储的访问

- 管道通信:管道是用于连接一个读进程和一个写进程以实现它们之间通信的一个共享文件 pipe 文件,该文件同一时间只允许一个进程访问,所以只支持半双工通信

- 匿名管道(Pipes):用于具有亲缘关系的父子进程间或者兄弟进程之间的通信

- 命名管道(Names Pipes):以磁盘文件的方式存在,可以实现本机任意两个进程通信,遵循 FIFO

- 消息队列:内核中存储消息的链表,由消息队列标识符标识,能在不同进程之间提供全双工通信,对比管道:

- 匿名管道存在于内存中的文件;命名管道存在于实际的磁盘介质或者文件系统;消息队列存放在内核中,只有在内核重启(操作系统重启)或者显示地删除一个消息队列时,该消息队列才被真正删除

- 读进程可以根据消息类型有选择地接收消息,而不像 FIFO 那样只能默认地接收

不同计算机之间的进程通信,需要通过网络,并遵守共同的协议,例如 HTTP

- 套接字:与其它通信机制不同的是,可用于不同机器间的互相通信

-

线程通信相对简单,因为线程之间共享进程内的内存,一个例子是多个线程可以访问同一个共享变量

- Java 中的通信机制:volatile、wait/notify机制、join 方式、InheritableThreadLocal、MappedByteBuffer

-

线程更轻量,线程上下文切换成本一般上要比进程上下文切换低

1.2 并发并行

单核cpu下,线程实际还是串行执行的。操作系统中有一个组件叫做任务调度器,将 cpu 的时间片(windows 下时间片最小约为 15 毫秒)分给不同的程序使用,只是由于 cpu 在线程间(时间片很短)的切换非常快,人类感觉是同时运行的。总结为一句话就是: 微观串行,宏观并行 。

一般会将这种线程轮流使用 CPU 的做法称为并发, concurrent

| CPU | 时间片 1 | 时间片 2 | 时间片 3 | 时间片 4 |

|---|---|---|---|---|

| core | 线程 1 | 线程 2 | 线程 3 | 线程 4 |

多核 cpu下,每个核(core) 都可以调度运行线程,这时候线程可以是并行的。

| CPU | 时间片 1 | 时间片 2 | 时间片 3 | 时间片 4 |

|---|---|---|---|---|

| core1 | 线程 1 | 线程 2 | 线程 3 | 线程 4 |

| core2 | 线程 4 | 线程 4 | 线程 2 | 线程 2 |

引用 Rob Pike 的一段描述:

并发(concurrent)是同一时间应对(dealing with)多件事情的能力 。[在同一时刻,有多条指令在单个 CPU 上交替执行]

并行(parallel)是同一时间动手做(doing)多件事情的能力。[在同一时刻,有多条指令在多个 CPU 上同时执行]

2. 线程

2.1 创建和运行线程

Thread

1 | // 构造方法的参数是给线程指定名字,推荐 |

Runnable

把【线程】和【任务】(要执行的代码)分开

- Thread 代表线程

- Runnable 可运行的任务(线程要执行的代码)

1 | // 创建任务对象 |

可以使用 lambda 精简代码

1 | // 创建任务对象 |

Thread 与 Runnable 的关系

1 | //Runnable源码 |

1 | //Thread源码(部分) |

FutureTask

FutureTask 能够接收 Callable 类型的参数,用来处理有返回结果的情况

1 | // 创建任务对象 |

源码分析

1 | //FutureTask源码(部分) |

1 | public interface RunnableFuture<V> extends Runnable, Future<V> { |

1 | //Callable源码 |

- FutureTask内置了一个Callable对象,初始化方法将指定的Callable赋给这个对象。

- FutureTask实现了Runnable接口,并重写了run方法,在run方法中调用了Callable中的call方法,并将返回值赋值给outcome变量

- get方法就是取出outcome的值。

2.2 查看进程线程的方法

windows

- 任务管理器可以查看进程和线程数,也可以用来杀死进程

- tasklist 查看进程

- tasklist | findstr (查找关键字)

- taskkill 杀死进程

- taskkill /F(彻底杀死)/PID(进程PID)

Linux

- ps -fe 查看所有进程

- ps -fT -p 查看某个进程(PID)的所有线程

- kill 杀死进程

- top 按大写 H 切换是否显示线程

- top -H -p 查看某个进程(PID)的所有线程

Java

- jps 命令查看所有 Java 进程

- jstack 查看某个 Java 进程(PID)的所有线程状态

- jconsole 来查看某个 Java 进程中线程的运行情况(图形界面)

jconsole 远程监控配置

-

需要以如下方式运行你的 java 类

java -Djava.rmi.server.hostname=`ip地址` -Dcom.sun.management.jmxremote - Dcom.sun.management.jmxremote.port=`连接端口` -Dcom.sun.management.jmxremote.ssl=是否安全连接 - Dcom.sun.management.jmxremote.authenticate=是否认证 java类

-

关闭防火墙,允许端口

-

修改 /etc/hosts 文件将 127.0.0.1 映射至主机名

如果要认证访问,还需要做如下步骤

- 复制 jmxremote.password 文件

- 修改 jmxremote.password 和 jmxremote.access 文件的权限为 600 即文件所有者可读写

- 连接时填入 controlRole(用户名),R&D(密码)

2.3 线程运行原理

运行机制

Java Virtual Machine Stacks(Java 虚拟机栈)

每个线程启动后,虚拟机就会为其分配一块栈内存

- 每个栈由多个栈帧(Frame)组成,对应着每次方法调用时所占用的内存

- 每个线程只能有一个活动栈帧,对应着当前正在执行的那个方法

线程上下文切换(Thread Context Switch)

一些原因导致 CPU 不再执行当前线程,转而执行另一个线程

- 线程的 CPU 时间片用完

- 垃圾回收

- 有更高优先级的线程需要运行

- 线程自己调用了 sleep、yield、wait、join、park 等方法

程序计数器(Program Counter Register)

记录下一条 JVM 指令的执行地址,是线程私有的

当 Context Switch 发生时,需要由操作系统保存当前线程的状态(PCB 中),并恢复另一个线程的状态,包括程序计数器、虚拟机栈中每个栈帧的信息,如局部变量、操作数栈、返回地址等

JVM 规范并没有限定线程模型,以 HotSopot 为例:

- Java 的线程是内核级线程(1:1 线程模型),每个 Java 线程都映射到一个操作系统原生线程,需要消耗一定的内核资源(堆栈)

- 线程的调度是在内核态运行的,而线程中的代码是在用户态运行,所以线程切换(状态改变)会导致用户与内核态转换进行系统调用,这非常消耗性能

Java 中 main 方法启动的是一个进程也是一个主线程,main 方法里面的其他线程均为子线程,main 线程是这些线程的父线程

线程调度

线程调度指系统为线程分配处理器使用权的过程,方式有两种:协同式线程调度、抢占式线程调度(Java 选择)

协同式线程调度:线程的执行时间由线程本身控制

- 优点:线程做完任务才通知系统切换到其他线程,相当于所有线程串行执行,不会出现线程同步问题

- 缺点:线程执行时间不可控,如果代码编写出现问题,可能导致程序一直阻塞,引起系统的奔溃

抢占式线程调度:线程的执行时间由系统分配

- 优点:线程执行时间可控,不会因为一个线程的问题而导致整体系统不可用

- 缺点:无法主动为某个线程多分配时间

Java 提供了线程优先级的机制,优先级会提示(hint)调度器优先调度该线程,但这仅仅是一个提示,调度器可以忽略它。在线程的就绪状态时,如果 CPU 比较忙,那么优先级高的线程会获得更多的时间片,但 CPU 闲时,优先级几乎没作用

说明:并不能通过优先级来判断线程执行的先后顺序

优化

内核级线程调度的成本较大,所以引入了更轻量级的协程。用户线程的调度由用户自己实现(多对一的线程模型,多个用户线程映射到一个内核级线程),被设计为协同式调度,所以叫协程

- 有栈协程:协程会完整的做调用栈的保护、恢复工作,所以叫有栈协程

- 无栈协程:本质上是一种有限状态机,状态保存在闭包里,比有栈协程更轻量,但是功能有限

有栈协程中有一种特例叫纤程,在新并发模型中,一段纤程的代码被分为两部分,执行过程和调度器:

- 执行过程:用于维护执行现场,保护、恢复上下文状态

- 调度器:负责编排所有要执行的代码顺序

2.4 线程方法

Thread 类 API:

| 方法 | 功能 | 说明 |

|---|---|---|

| start() | 启动一个新线程;Java虚拟机调用此线程的run方法 | start 方法只是让线程进入就绪,里面代码不一定立刻 运行(CPU 的时间片还没分给它)。每个线程对象的 start方法只能调用一次,如果调用了多次会出现 IllegalThreadStateException |

| run() | 线程启动后调用该方法 | 如果在构造 Thread 对象时传递了 Runnable 参数,则 线程启动后会调用 Runnable 中的 run 方法,否则默认不执行任何操作。但可以创建 Thread 的子类对象, 来覆盖默认行为 |

| setName(String name) | 给当前线程取名字 | |

| getName() | 获取当前线程的名字。线程存在默认名称:子线程是Thread-索引,主线程是main | |

| currentThread() | 获取当前线程对象,代码在哪个线程中执行 | |

| sleep(long time) | 让当前线程休眠多少毫秒再继续执行。Thread.sleep(0) : 让操作系统立刻重新进行一次cpu竞争 | |

| yield() | 提示线程调度器让出当前线程对CPU的使用 | 主要是为了测试和调试 |

| getPriority() | 返回此线程的优先级 | |

| setPriority(int priority) | 更改此线程的优先级,常用1、5、10 | java中规定线程优先级是1~10 的整数,较大的优先级 能提高该线程被 CPU 调度的机率 |

| interrupt() | 中断这个线程,异常处理机制 | |

| interrupted() | 判断当前线程是否被打断,清除打断标记 | |

| isInterrupted() | 判断当前线程是否被打断,不清除打断标记 | |

| join() | 等待这个线程结束 | |

| join(long millis) | 等待这个线程死亡millis毫秒,0意味着永远等待 | |

| isAlive() | 线程是否存活(还没有运行完毕) | |

| setDaemon(boolean on) | 将此线程标记为守护线程或用户线程 | |

| getId() | 获取线程长整型 的 id | id 唯一 |

| getState() | 获取线程状态 | Java 中线程状态是用 6 个 enum 表示,分别为: NEW, RUNNABLE, BLOCKED, WAITING, TIMED_WAITING, TERMINATED |

2.4.1 start与run

-

直接调用 run 是在主线程中执行了 run,没有启动新的线程

-

使用 start 是启动新的线程,通过新的线程间接执行 run 中的代码

1

2

3

4

5

6

7

8

9

10

11public static void main(String[] args) {

Thread t1 = new Thread("t1") {

public void run() {

log.debug("running...");

}

};

System.out.println(t1.getState());

t1.start();

System.out.println(t1.getState());

}可以看见,start方法创建了一个新线程,将线程从就绪状态切换为Runnable

NEW RUNNABLE 03:45:12.255 c.Test5 [t1] - running...

2.4.2 sleep与yield

sleep

- 调用 sleep 会让当前线程从

Running进入Timed Waiting状态(阻塞) - 其它线程可以使用 interrupt 方法打断正在睡眠的线程,这时 sleep 方法会抛出 InterruptedException

1 | public static void main(String[] args) throws InterruptedException { |

输出结果:

03:47:18.141 c.Test7 [t1] - enter sleep... 03:47:19.132 c.Test7 [main] - interrupt... 03:47:19.132 c.Test7 [t1] - wake up... java.lang.InterruptedException: sleep interrupted at java.lang.Thread.sleep(Native Method) at cn.itcast.test.Test7$1.run(Test7.java:14)

- 睡眠结束后的线程未必会立刻得到执行,需要抢占 CPU

- 建议用 TimeUnit 的 sleep 代替 Thread 的 sleep 来获得更好的可读性,其底层还是sleep方法。

1 |

|

- 在循环访问锁的过程中,可以加入sleep让线程阻塞时间,防止大量占用cpu资源。

yield

- 调用 yield 会让当前线程从 Running 进入 Runnable 就绪状态,然后调度执行其它线程

- 具体的实现依赖于操作系统的任务调度器

线程优先级

- 线程优先级会提示(hint)调度器优先调度该线程,但它仅仅是一个提示,调度器可以忽略它

- 如果 cpu 比较忙,那么优先级高的线程会获得更多的时间片,但 cpu 闲时,优先级几乎没作用

测试优先级和yield

1 |

|

测试结果:

#优先级 ---->1 283500 ---->2 374389 #yield ---->1 119199 ---->2 101074

可以看出,线程优先级和yield会对线程获取cpu时间片产生一定影响,但不会影响太大。

*应用之限制

1. sleep 实现

在没有利用 cpu 来计算时,不要让 while(true) 空转浪费 cpu,这时可以使用 yield 或 sleep 来让出 cpu 的使用权 给其他程序

1 | while(true) { |

- 可以用 wait 或 条件变量达到类似的效果

- 不同的是,后两种都需要加锁,并且需要相应的唤醒操作,一般适用于要进行同步的场景

- sleep 适用于无需锁同步的场景

2. wait 实现

1 | synchronized(锁对象) { |

3. 条件变量实现

1 | lock.lock(); |

2.4.3 join

下面的代码执行,打印 r 是什么?

1 | static int r = 0; |

分析

- 因为主线程和线程 t1 是并行执行的,t1 线程需要 1 秒之后才能算出 r=10

- 而主线程一开始就要打印 r 的结果,所以只能打印出 r=0

解决方法

- 用 join,加在 t1.start() 之后即可

*应用之同步

以调用方角度来讲,如果

- 需要等待结果返回,才能继续运行就是同步

- 不需要等待结果返回,就能继续运行就是异步

1. 等待多个结果

问,下面代码 cost 大约多少秒?

1 | static int r1 = 0; |

分析

- 第一个 join:等待 t1 时, t2 并没有停止, 而在运行

- 第二个 join:1s 后, 执行到此, t2 也运行了 1s, 因此也只需再等待 1s

如果颠倒两个 join 呢?

最终都是输出

20:45:43.239 [main] c.TestJoin - r1: 10 r2: 20 cost: 2005

2. 有时效的join

当线程执行时间没有超过join设定时间

1 | static int r1 = 0; |

输出

20:48:01.320 [main] c.TestJoin - r1: 10 r2: 0 cost: 1010

当执行时间超时

1 | static int r1 = 0; |

输出

20:52:15.623 [main] c.TestJoin - r1: 0 r2: 0 cost: 1502

3. 原理

public final void join():等待这个线程结束

原理:调用者轮询检查线程 alive 状态,t1.join() 等价于:

1 | // Thread类中的join()方法实现 |

- join 方法是被 synchronized 修饰的,本质上是一个对象锁,这意味着它使用对象的内置锁(monitor lock)来实现同步,调用join()方法时,当前线程会获取调用join()方法的那个线程对象的内置锁;join()方法内部会调用wait(),使当前线程等待,wait()释放的是当前线程对象的内置锁,而不是调用join()方法的线程所持有的任何其他锁

- 当调用某个线程(t1)的 join 方法后,该线程(t1)抢占到 CPU 资源,就不再释放,直到线程执行完毕

1 | // 伪代码说明 |

线程同步:

- join 实现线程同步,因为会阻塞等待另一个线程的结束,才能继续向下运行

- 需要外部共享变量,不符合面向对象封装的思想

- 必须等待线程结束,不能配合线程池使用

- Future 实现同步,get() 方法阻塞等待执行结果

- main 线程接收结果

- get 方法是让调用线程同步等待

2.4.4 interrupt

Interrupt说明

interrupt的本质是将线程的打断标记设为true,并调用线程的三个parker对象(C++实现级别)unpark该线程。

基于以上本质,有如下说明:

-

打断线程不等于中断线程,有以下两种情况:

- 打断正在运行中的线程并不会影响线程的运行,但如果线程监测到了打断标记为true,可以自行决定后续处理。

- 打断阻塞中的线程会让此线程产生一个

InterruptedException异常,结束线程的运行。但如果该异常被线程捕获住,该线程依然可以自行决定后续处理(终止运行,继续运行,做一些善后工作等等)

public void interrupt():打断这个线程,异常处理机制

public static boolean interrupted():判断当前线程是否被打断,打断返回 true,清除打断标记,连续调用两次一定返回 false

public boolean isInterrupted():判断当前线程是否被打断,不清除打断标记

打断的线程会发生上下文切换,操作系统会保存线程信息,抢占到 CPU 后会从中断的地方接着运行(打断不是停止)

1. 打断sleep,wait,join 的线程

这几个方法都会让线程进入阻塞状态,打断线程会清空打断状态(false),以 sleep 为例

1 | public static void main(String[] args) throws InterruptedException { |

2. 打断正常运行的线程

打断正常运行的线程, 不会清空打断状态(true)

1 | public static void main(String[] args) throws Exception { |

3. 打断 park 线程

park 作用类似 sleep,打断 park 线程,不会清空打断状态(true)

1 | private static void test3() throws InterruptedException { |

如果打断标记已经是 true, 则 park 会失效

1 | private static void test4()throws InterruptedException { |

输出

23:15:37.109 [Thread-0] INFO com.lxd.juc.TPTVolatile -- park... 23:15:38.110 [Thread-0] INFO com.lxd.juc.TPTVolatile -- 打断状态:true 23:15:38.114 [Thread-0] INFO com.lxd.juc.TPTVolatile -- park... 23:15:38.115 [Thread-0] INFO com.lxd.juc.TPTVolatile -- 打断状态:true 23:15:38.115 [Thread-0] INFO com.lxd.juc.TPTVolatile -- park... 23:15:38.115 [Thread-0] INFO com.lxd.juc.TPTVolatile -- 打断状态:true 23:15:38.115 [Thread-0] INFO com.lxd.juc.TPTVolatile -- park... 23:15:38.115 [Thread-0] INFO com.lxd.juc.TPTVolatile -- 打断状态:true 23:15:38.115 [Thread-0] INFO com.lxd.juc.TPTVolatile -- park... 23:15:38.115 [Thread-0] INFO com.lxd.juc.TPTVolatile -- 打断状态:true

可以修改获取打断状态方法,使用

Thread.interrupted(),清除打断标记

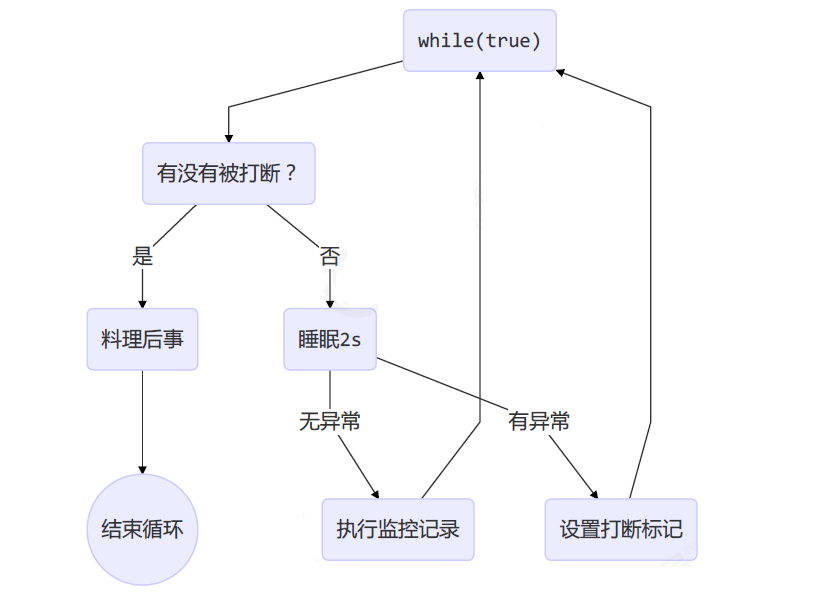

*模式之两阶段终止

终止模式之两阶段终止模式:Two Phase Termination

目标:在一个线程 T1 中如何优雅终止线程 T2?优雅指的是给 T2 一个料理后事的机会。

错误思想:

- 使用线程对象的 stop() 方法停止线程:stop 方法会真正杀死线程,如果这时线程锁住了共享资源,当它被杀死后就再也没有机会释放锁,其它线程将永远无法获取锁

- 使用 System.exit(int) 方法停止线程:目的仅是停止一个线程,但这种做法会让整个程序都停止

两阶段终止模式图示:

1. 利用 isInterrupted

interrupt 可以打断正在执行的线程,无论这个线程是在 sleep,wait,还是正常运行

1 |

|

调用

1 | public class Test { |

结果

23:06:45.164 [监控线程] INFO com.lxd.rbac.TwoPhaseTermination -- 执行监控记录 23:06:46.172 [监控线程] INFO com.lxd.rbac.TwoPhaseTermination -- 执行监控记录 23:06:47.176 [监控线程] INFO com.lxd.rbac.TwoPhaseTermination -- 执行监控记录 23:06:47.659 [main] INFO com.lxd.rbac.TwoPhaseTermination -- stop 23:06:47.660 [监控线程] INFO com.lxd.rbac.TwoPhaseTermination -- 料理后事

2. 利用停止标记

1 | // 停止标记用 volatile 是为了保证该变量在多个线程之间的可见性 |

调用

1 | public static void main(String[] args) throws InterruptedException { |

结果

23:09:29.477 [监控线程] INFO com.lxd.rbac.TPTVolatile -- 执行监控记录 23:09:30.484 [监控线程] INFO com.lxd.rbac.TPTVolatile -- 执行监控记录 23:09:31.488 [监控线程] INFO com.lxd.rbac.TPTVolatile -- 执行监控记录 23:09:31.973 [main] INFO com.lxd.rbac.TPTVolatile -- stop 23:09:31.973 [监控线程] INFO com.lxd.rbac.TPTVolatile -- 料理后事

2.4.5 不推荐使用的方法

这些方法已过时,容易破坏同步代码块,造成线程死锁:

-

public final void stop():停止线程运行废弃原因:方法粗暴,除非可能执行 finally 代码块以及释放 synchronized 外,线程将直接被终止,如果线程持有 JUC 的互斥锁可能导致锁来不及释放,造成其他线程永远等待的局面 -

public final void suspend():挂起(暂停)线程运行废弃原因:如果目标线程在暂停时对系统资源持有锁,则在目标线程恢复之前没有线程可以访问该资源,如果恢复目标线程的线程在调用 resume 之前会尝试访问此共享资源,则会导致死锁 -

public final void resume():恢复线程运行

2.4.6 主线程与守护线程

默认情况下,Java 进程需要等待所有线程都运行结束,才会结束。有一种特殊的线程叫做守护线程,只要其它非守护线程运行结束了,即使守护线程的代码没有执行完,也会强制结束。

用户线程:平常创建的普通线程

守护线程:服务于用户线程,只要其它非守护线程运行结束了,即使守护线程代码没有执行完,也会强制结束。守护进程是脱离于终端并且在后台运行的进程,脱离终端是为了避免在执行的过程中的信息在终端上显示

说明:当运行的线程都是守护线程,Java 虚拟机将退出,因为普通线程执行完后,JVM 是守护线程,不会继续运行下去

public final void setDaemon(boolean on):如果是 true ,将此线程标记为守护线程

1 |

|

结果

23:22:18.478 [main] INFO com.lxd.juc.TestDaemon -- 开始运行... 23:22:18.479 [daemon] INFO com.lxd.juc.TestDaemon -- 开始运行... 23:22:19.480 [main] INFO com.lxd.juc.TestDaemon -- 运行结束...

- 垃圾回收器线程就是一种守护线程

- Tomcat 中的 Acceptor 和 Poller 线程都是守护线程,所以 Tomcat 接收到 shutdown 命令后,不会等待它们处理完当前请求

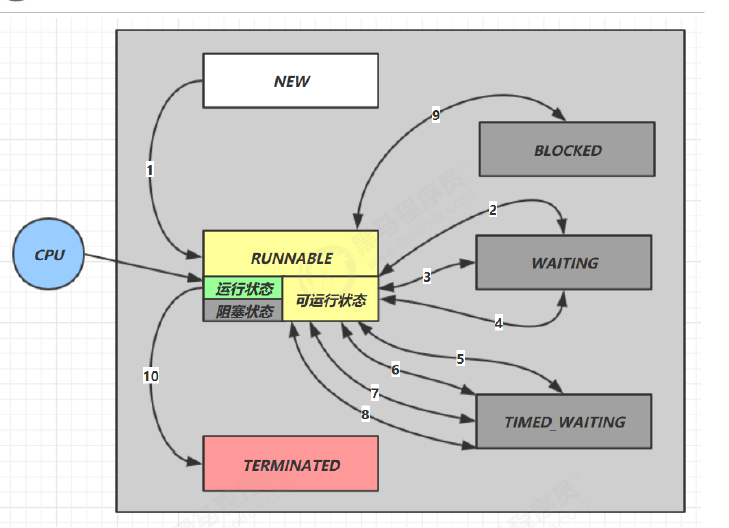

2.5 线程状态

五种状态

这是从 操作系统 层面来描述的

- 【初始状态】仅是在语言层面创建了线程对象,还未与操作系统线程关联

- 【可运行状态】(就绪状态)指该线程已经被创建(与操作系统线程关联),可以由 CPU 调度执行

- 【运行状态】指获取了 CPU 时间片运行中的状态

- 当 CPU 时间片用完,会从【运行状态】转换至【可运行状态】,会导致线程的上下文切换

- 【阻塞状态】

- 如果调用了阻塞 API,如 BIO 读写文件,这时该线程实际不会用到 CPU,会导致线程上下文切换,进入 【阻塞状态】

- 等 BIO 操作完毕,会由操作系统唤醒阻塞的线程,转换至【可运行状态】

- 与【可运行状态】的区别是,对【阻塞状态】的线程来说只要它们一直不唤醒,调度器就一直不会考虑 调度它们

- 【终止状态】表示线程已经执行完毕,生命周期已经结束,不会再转换为其它状态

六种状态

这是从 Java API 层面来描述的

java.lang.Thread.State 这个枚举中给出了六种线程状态:

| 线程状态 | 导致状态发生条件 |

|---|---|

| NEW(新建) | 线程刚被创建,但是并未启动,还没调用 start 方法,只有线程对象,没有线程特征 |

| Runnable(可运行) | 线程可以在 Java 虚拟机中运行的状态,可能正在运行自己代码,也可能没有,这取决于操作系统处理器,调用了 t.start() 方法:就绪(经典叫法) |

| Blocked(阻塞) | 当一个线程试图获取一个对象锁,而该对象锁被其他的线程持有,则该线程进入 Blocked 状态;当该线程持有锁时,该线程将变成 Runnable 状态 |

| Waiting(无限等待) | 一个线程在等待另一个线程执行一个(唤醒)动作时,该线程进入 Waiting 状态,进入这个状态后不能自动唤醒,必须等待另一个线程调用 notify 或者 notifyAll 方法才能唤醒 |

| Timed Waiting (限期等待) | 有几个方法有超时参数,调用将进入 Timed Waiting 状态,这一状态将一直保持到超时期满或者接收到唤醒通知。带有超时参数的常用方法有 Thread.sleep 、Object.wait |

| Teminated(结束) | run 方法正常退出而死亡,或者因为没有捕获的异常终止了 run 方法而死亡 |

-

NEW 线程刚被创建,但是还没有调用 start() 方法

-

RUNNABLE 当调用了 start() 方法之后,注意,Java API 层面的 RUNNABLE 状态涵盖了 操作系统 层面的 【可运行状态】、【运行状态】和【阻塞状态】(由于 BIO 导致的线程阻塞,在 Java 里无法区分,仍然认为 是可运行)

-

BLOCKED , WAITING , TIMED_WAITING 都是 Java API 层面对【阻塞状态】的细分,后面会在状态转换一节 详述

-

TERMINATED 当线程代码运行结束

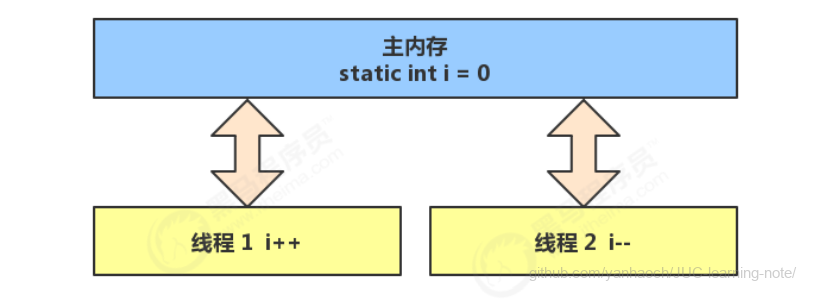

3. 共享模型之管程

3.1 共享带来的问题

两个线程对初始值为 0 的静态变量一个做自增,一个做自减,各做 5000 次,结果是 0 吗?

1 | static int counter = 0; |

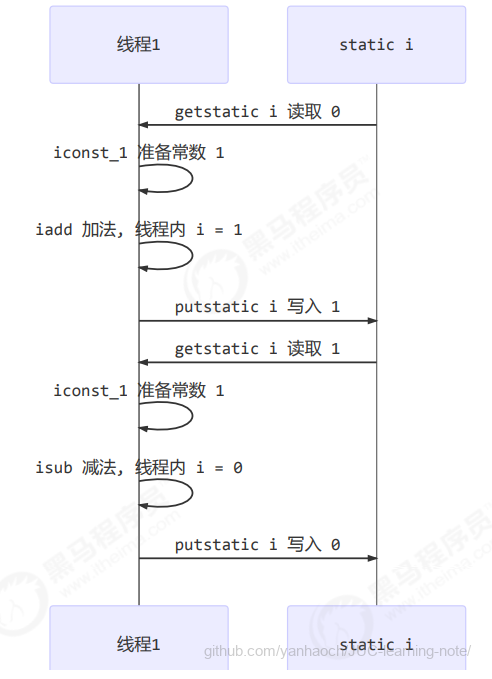

问题分析

以上的结果可能是正数、负数、零。

因为 Java 中对静态变量的自增,自减并不是原子操作,要彻底理解,必须从字节码来进行分析

例如对于 i++ 而言(i 为静态变量),实际会产生如下的 JVM 字节码指令:

1 | getstatic i // 获取静态变量i的值 |

而对应 i-- 也是类似:

1 | getstatic i // 获取静态变量i的值 |

而 Java 的内存模型如下,完成静态变量的自增,自减需要在主存和工作内存中进行数据交换:

如果是单线程以上 8 行代码是顺序执行(不会交错)没有问题:

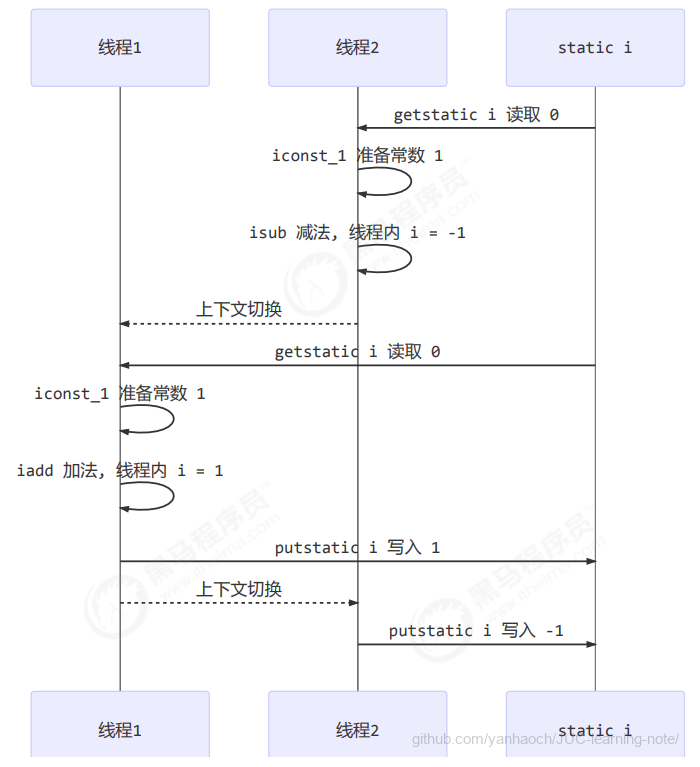

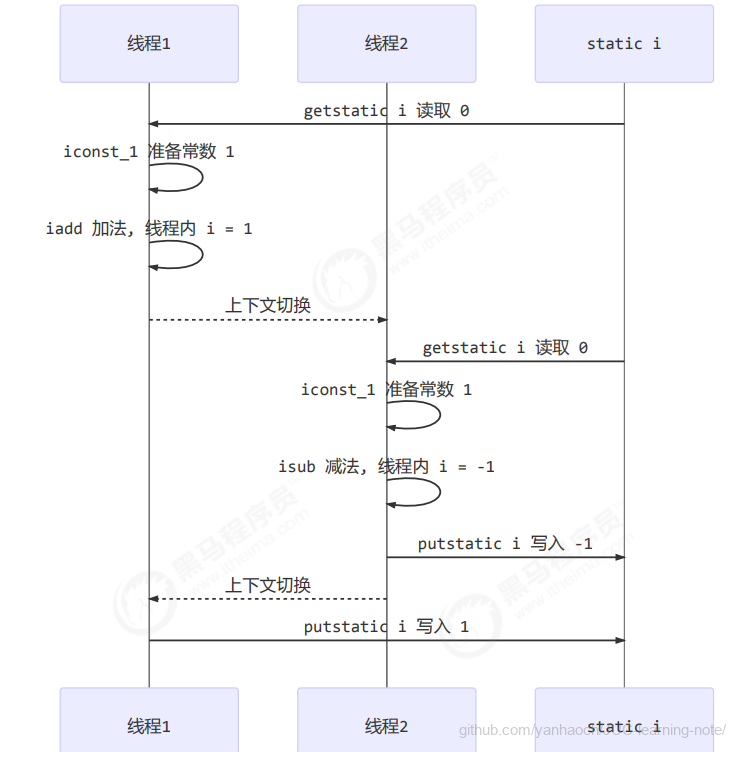

但多线程下这 8 行代码可能交错运行

出现负数的情况

出现正数的情况

临界区 Critical Section

- 一段程序运行多个线程本身是没有问题的

- 问题出在多个线程访问**

共享资源**- 多个线程读**

共享资源**其实也没有问题 - 在多个线程对**

共享资源**读写操作时发生指令交错,就会出现问题

- 多个线程读**

- 一段代码块内如果存在对共享资源的多线程读写操作,称这段代码块为**

临界区**

1 | static int counter = 0; |

竞态条件 Race Condition

多个线程在临界区内执行,由于代码的**执行序列不同而导致结果无法预测,称之为发生了竞态条件**

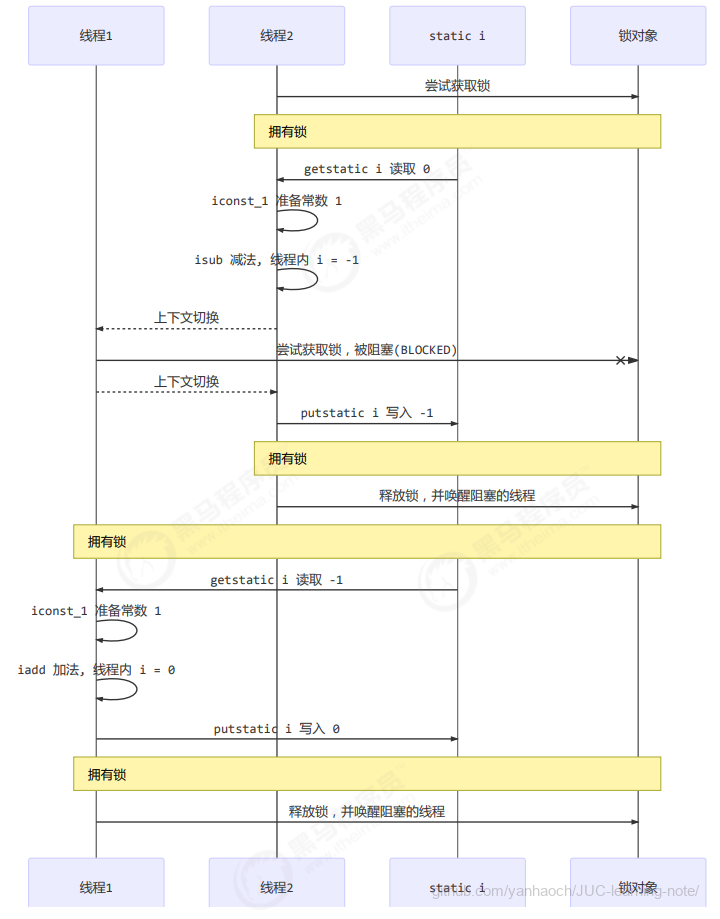

3.2 synchronized解决方案

为了避免临界区的竞态条件发生,有多种手段可以达到目的。

- 阻塞式的解决方案:synchronized,Lock

- 非阻塞式的解决方案:原子变量

本次课使用阻塞式的解决方案:synchronized,来解决上述问题,即俗称的【对象锁】,它采用互斥的方式让同一时刻至多只有一个线程能持有【对象锁】,其它线程再想获取这个【对象锁】时就会阻塞住。这样就能保证拥有锁的线程可以安全的执行临界区内的代码,不用担心线程上下文切换

注意

虽然 java 中互斥和同步都可以采用 synchronized 关键字来完成,但它们还是有区别的:

- 互斥的核心目标是解决竞态条件问题,确保同一时刻只有一个线程能够访问共享资源或执行临界区代码。

- 同步关注的是线程间的执行顺序和协作,确保某些操作按照特定顺序执行。

3.2.1 synchronized

语法

1 | synchronized(对象) // 线程1, 线程2(blocked) |

解决

1 | static int counter = 0; |

图示流程

synchronized 实际是用对象锁保证了临界区内代码的原子性,临界区内的代码对外是不可分割的,不会被线程切换所打断。

面向对象改进

把需要保护的共享变量放入一个类

1 | class Room { |

3.2.2 方法上的 synchronized

把出现线程安全问题的核心方法锁起来,每次只能一个线程进入访问

synchronized 修饰的方法的不具备继承性

-

若父类方法被 synchronized 修饰,子类重写该方法时不会自动继承同步修饰符。子类方法需显式添加 synchronized 才能保证线程安全。

-

当子类重写父类同步方法并也添加 synchronized 时,两者的锁对象均为子类实例(即

this),因此是同一把锁。

用法:直接给方法加上一个修饰符 synchronized

同步方法底层也是有锁对象的:

-

如果方法是实例方法:同步方法默认用

this作为的锁对象1

2

3

4

5

6

7

8

9

10

11

12

13class Test{

public synchronized void test() {

}

}

//等价于

class Test{

public void test() {

synchronized(this) {

}

}

}反编译的结果如下图所示,可以看到 test 方法的 flag 包含

ACC_SYNCHRONIZED标志位public synchronized void test(); descriptor: ()V flags: (0x0021) ACC_PUBLIC, ACC_SYNCHRONIZED Code: stack=0, locals=1, args_size=1 0: return LineNumberTable: line 6: 0JVM 对于方法级别的同步是隐式的,是方法调用和返回值的一部分。同步方法在运行时常量池的 method_info 结构中由

ACC_SYNCHRONIZED标志来区分,它由方法调用指令来检查。当调用设置了 ACC_SYNCHRONIZED 标志位的方法时,调用线程会获取 monitor,调用方法本身,再退出 monitor。 -

如果方法是静态方法:同步方法默认用

类名.class作为的锁对象1

2

3

4

5

6

7

8

9

10

11

12class Test{

public synchronized static void test() {

}

}

等价于

class Test{

public static void test() {

synchronized(Test.class) {

}

}

}

3.2.3 线程八锁

线程八锁就是考察 synchronized 锁住的是哪个对象

说明:主要关注锁住的对象是不是同一个

- 锁住类对象,所有类的实例的方法都是安全的,类的所有实例都相当于同一把锁

- 锁住 this 对象,只有在当前实例对象的线程内是安全的,如果有多个实例就不安全

1️⃣ 12 或 21

1 | class Number{ |

2️⃣ 1s后12,或 2 1s后 1

1 | class Number{ |

3️⃣ 3 1s 12 或 23 1s 1 或 32 1s 1

1 | class Number{ |

4️⃣ 2 1s 后 1

1 | class Number{ |

5️⃣ 2 1s 后 1

1 | class Number{ |

6️⃣ 1s 后12,或 2 1s后 1

1 | class Number{ |

7️⃣ 2 1s 后 1

1 | class Number{ |

8️⃣ 1s 后12,或 2 1s后 1

1 | class Number{ |

3.3 变量的线程安全分析

成员变量和静态变量是否线程安全?

- 如果它们没有共享,则线程安全

- 如果它们被共享了,根据它们的状态是否能够改变,又分两种情况

- 如果只有读操作,则线程安全

- 如果有读写操作,则这段代码是临界区,需要考虑线程安全

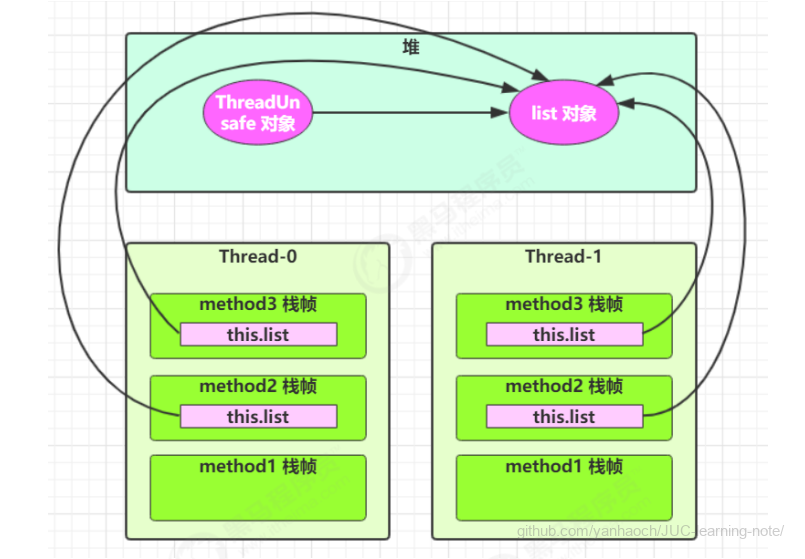

3.3.1 成员变量线程安全分析

1 | class ThreadUnsafe { |

执行

1 | static final int THREAD_NUMBER = 2; |

其中一种情况是,如果线程2 还未 add,线程1 remove 就会报错:

Exception in thread "Thread1" java.lang.IndexOutOfBoundsException: Index: 0, Size: 0 at java.util.ArrayList.rangeCheck(ArrayList.java:657) at java.util.ArrayList.remove(ArrayList.java:496) at cn.itcast.n6.ThreadUnsafe.method3(TestThreadSafe.java:35) at cn.itcast.n6.ThreadUnsafe.method1(TestThreadSafe.java:26) at cn.itcast.n6.TestThreadSafe.lambda$main$0(TestThreadSafe.java:14) at java.lang.Thread.run(Thread.java:748)

分析:

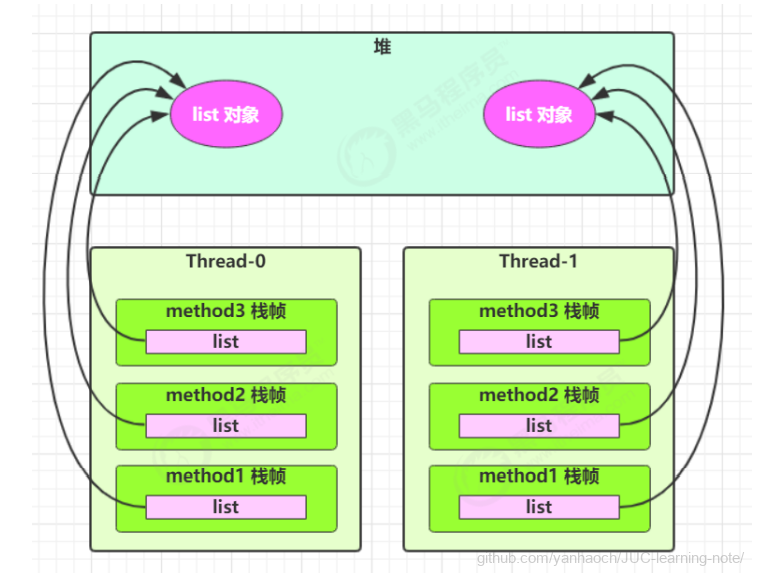

- 无论在哪个线程中 method2 引用的都是同一个对象中的 list 成员变量

- method3 与 method2 分析相同

局部变量是否线程安全?

- 局部变量是线程安全的

- 但局部变量引用的对象则未必

- 如果该对象没有逃离方法的作用访问,它是线程安全的

- 如果该对象逃离方法的作用范围,需要考虑线程安全

3.3.2 局部变量线程安全分析

1 | public static void test1() { |

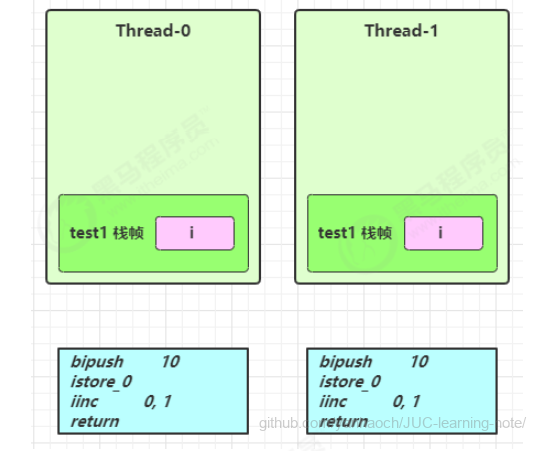

每个线程调用 test1() 方法时局部变量 i,会在每个线程的栈帧内存中被创建多份,因此不存在共享

1 | public static void test1(); |

如图

1 | class ThreadSafe { |

将 list 修改为局部变量,就不会有上述问题了

分析:

- list 是局部变量,每个线程调用时会创建其不同实例,没有共享

- 而 method2 的参数是从 method1 中传递过来的,与 method1 中引用同一个对象

- method3 的参数分析与 method2 相同

3.3.3 局部变量的引用

方法访问修饰符带来的思考,如果把 method2 和 method3 的方法修改为 public 会不会带来线程安全问题?

- 情况1:有其它线程调用 method2 和 method3

- 情况2:在 情况1 的基础上,为 ThreadSafe 类添加子类,子类覆盖 method2 或 method3 方法

1 | class ThreadSafe { |

从这个例子可以看出 private 或 final 提供【安全】的意义所在,请体会开闭原则中的【闭】

3.3.4 对象共享快速诊断指南

一、作用域追踪(核心法则)

-

局部变量:仅当前方法可见 → 不共享

1

2

3void method() {

Object localObj = new Object(); // 未逃逸 → 不共享

} -

类成员变量:实例/静态变量 → 默认共享

1

2

3

4class Shared {

Object instanceObj; // 实例共享

static Object staticObj; // 全局共享

}

二、引用传播分析(3种危险路径)

-

直接暴露:通过返回值或参数传递引用

1

2

3

4public Object leak() {

Object obj = new Object();

return obj; // 引用逃逸!

} -

间接注册:加入集合/注册回调

1

2

3

4void register() {

Object obj = new Object();

eventBus.register(obj); // 隐式共享

} -

跨线程传递:提交给线程池/异步任务

1

2

3

4void asyncTask() {

List data = new ArrayList();

executor.execute(() -> use(data)); // 线程共享

}

三、线程安全注解检测(开发规范)

@GuardedBy注解

-

作用

明确标识变量或方法的访问必须持有指定锁(显式锁/内置锁),用于防止并发访问冲突。 -

典型用法

1

2

3

4

5

6

7

8

private List<String> sharedList = new ArrayList<>();

public void addItem(String item) {

synchronized (lock) { // 必须与注解声明的锁一致

sharedList.add(item);

}

} -

检测要点

- 静态代码分析工具(如ErrorProne)会验证锁的实际使用是否与注解匹配。

- 锁类型支持:

this、Class对象、显式Lock实例或字符串指定的锁名。

@Immutable注解

-

作用

标记不可变类(所有字段final且无状态),保证线程安全无需同步。 -

验证条件

- 所有字段必须声明为

final。 - 字段类型本身不可变(如

String)或引用对象的内部状态不可变。 - 无方法能修改对象状态(无

setter方法)。

- 所有字段必须声明为

-

示例

1

2

3

4

5

6

7

8

9

10

11

public final class SafePoint {

private final int x;

private final int y; // 基本类型+final满足条件

public SafePoint(int x, int y) {

this.x = x;

this.y = y;

}

// 仅提供访问方法,无修改方法

}

四、运行时验证技巧

-

HashCode监控:

1

# 通过jstack检查不同线程中相同hashCode的对象

-

内存分析工具:

1

// 使用VisualVM/YourKit查看对象引用链

3.4 常见线程安全类

- String

- Integer

- StringBuffer

- Random

- Vector

- Hashtable

- java.util.concurrent 包下的类

这里说它们是线程安全的是指,多个线程调用它们同一个实例的某个方法时,是线程安全的。也可以理解为

- 它们的每个方法是原子的

- 但

注意它们多个方法的组合不是原子的,见后面分析

3.4.1 线程安全类方法的组合

分析下面代码是否线程安全?

1 | Hashtable table = new Hashtable(); |

3.4.2 不可变类线程安全性

String、Integer 等都是不可变类,因为其内部的状态不可以改变,因此它们的方法都是线程安全的

你或许有疑问,String 有 replace,substring 等方法【可以】改变值啊,那么这些方法又是如何保证线程安全的呢?

1. 不可变对象的定义

- 不可变性(Immutability):对象一旦创建,其内部状态(字段值)永远不能被修改。

- 例如:

String s = "abc";,"abc"这个值在内存中始终不变,任何操作(如s.replace("a", "x"))只会生成新对象"xbc",原对象"abc"依然存在。

- 例如:

2. 线程安全的本质

- 多线程环境下的风险:当多个线程同时读写共享数据时,可能因竞争导致数据不一致(如脏读、覆盖写)。

- 不可变对象的优势:

- 只读不写:所有线程只能读取

String的值,无法修改它。 - 无竞态条件:因为不存在“修改”操作,所以不需要同步(如

synchronized或锁)。

- 只读不写:所有线程只能读取

3. 具体场景分析

假设以下代码:

1 | String sharedStr = "Hello"; |

-

线程安全的表现:

- 线程1 调用

replace("H", "X"),生成新对象"Xello",原对象"Hello"不变。 - 线程2 同样生成新对象

"Xello",与线程1 的操作完全独立。

- 无冲突:两个线程互不干扰,无需加锁。

- 线程1 调用

4. 对比可变对象的线程安全问题

若 sharedStr 是 StringBuilder(可变):

1 | StringBuilder sharedStr = new StringBuilder("Hello"); |

- 风险:两个线程可能同时修改内部字符数组,导致数据丢失或异常,必须通过同步解决。

5. 不可变性的实现保障

- Java 语言机制:

String的char[] value字段是final的,初始化后引用不可变。- 所有方法(如

substring、replace)均返回新对象,绝不修改原数据。

6. 总结

“无需同步”的本质是:

- 不可变对象的所有操作都是只读的,多线程并发时不存在写竞争,因此无需额外同步措施。

- 这是最彻底的线程安全方案,优于加锁或原子类,但代价是可能产生更多对象(需权衡内存开销)。

1 | public class Immutable{ |

如果想增加一个新增的方法呢?

1 | public class Immutable{ |

3.4.3 实例分析

例1:

1 | public class MyServlet extends HttpServlet { |

例2:

1 | public class MyServlet extends HttpServlet { |

线程不安全原因分析

- Servlet单例模式导致的共享状态

- 根本机制:Servlet容器默认以单例模式管理

MyServlet,所有HTTP请求共享同一个userService实例 - 危险表现:当多个请求同时调用

doGet()时,会并发操作同一个UserServiceImpl中的count计数器 - 数据竞争:

count++操作非原子性(包含读取-修改-写入三步),可能导致计数丢失

- 成员变量未做同步保护

-

count自增问题:count++ 实际等效于:

1

2

3int tmp = count; // 读操作

tmp = tmp + 1; // 计算

count = tmp; // 写操作 -

并发后果:两个线程可能同时读取到相同的count值,导致最终结果少计

- Service层设计缺陷

- 有状态服务:

UserServiceImpl包含可变的count成员变量,但未声明为线程安全 - 设计反模式:服务层对象应设计为无状态(stateless),或将状态明确隔离

例3:

1 |

|

线程不安全核心原因

- 成员变量共享污染

-

根本机制:Spring默认单例管理切面类,所有切点方法共享同一个

start变量 -

并发场景:

1

2

3// 线程A调用method1() 线程B调用method2()

→ 写入start=100 → 写入start=200

→ 读取start(200) → 读取start(200) -

结果异常:两个方法的耗时计算都会基于错误的

start值

- 时间记录逻辑缺陷

- 竞态条件:

before()和after()方法非原子操作 - 典型问题序列:

- 线程A执行

before()设置start=100 - 线程B执行

before()覆盖start=200 - 线程A执行

after()读取到错误值200

- 线程A执行

- AOP通知设计不当

-

设计反模式:使用成员变量记录临时状态,违反无状态切面原则

-

Spring官方警告:

“Aspect instances are singletons by default. Do not use instance variables for state that needs to be maintained per-request.”

例4:

1 | public class MyServlet extends HttpServlet { |

线程安全评估(三层架构分析)

- Servlet层(MyServlet)

- 安全✅

- 虽然Servlet是单例,但

UserServiceImpl无共享状态 - 每次请求都会创建新的数据库连接(见Dao层分析)

- 虽然Servlet是单例,但

- Service层(UserServiceImpl)

- 安全✅

- 仅持有

UserDao引用,不维护可变状态 - 符合无状态服务设计原则

- 仅持有

- Dao层(UserDaoImpl)

- 安全✅

- 使用局部变量

Connection(每个线程独立) - 采用try-with-resources确保连接释放

- SQL语句作为局部变量不会共享

- 使用局部变量

例5:

1 | public class MyServlet extends HttpServlet { |

线程安全评估(三层架构分析)

- Servlet层(MyServlet)

- 安全✅

- 虽然Servlet是单例,但

UserServiceImpl无共享状态 - 每次请求理论上应该创建新的数据库连接(但Dao层实现有问题)

- 虽然Servlet是单例,但

- Service层(UserServiceImpl)

- 安全✅

- 仅持有

UserDao引用,不维护可变状态 - 符合无状态服务设计原则

- 仅持有

- Dao层(UserDaoImpl)

-

不安全❌

核心问题:

Connection作为成员变量被所有线程共享- 并发请求会导致连接对象被覆盖(可能引发:连接泄漏/事务混乱/SQL执行错乱)

- 未使用try-with-resources,连接可能无法正确关闭

例6:

1 | public class MyServlet extends HttpServlet { |

线程安全评估(关键变化分析)

- Servlet层(MyServlet)

- 安全✅

- 单例Servlet持有单例UserService

- 但UserServiceImpl现在改为方法内创建Dao(见下文分析)

- Service层(UserServiceImpl)

-

安全✅

重大改进:

1

2

3

4public void update() {

UserDao userDao = new UserDaoImpl(); // 每次调用新建Dao实例

userDao.update();

}- 将Dao实例化从成员变量改为局部变量

- 每个请求独立创建Dao对象,消除共享状态

- Dao层(UserDaoImpl)

-

理论安全⚠️(但存在严重设计缺陷)

看似安全的原因:

- 每个Dao实例被单个线程临时使用

- 连接对象(conn)虽然为成员变量,但不会被并发访问

实际隐患:

- ❌ 连接未及时关闭(可能泄漏)

- ❌ 未使用try-with-resources

- ❌ 多次调用update()会覆盖连接(单线程也会泄漏)

例7:

1 | public abstract class Test { |

其中 foo 的行为是不确定的,可能导致不安全的发生,被称之为外星方法

1 | public void foo(SimpleDateFormat sdf) { |

线程安全评估

1. 核心问题分析

- SimpleDateFormat线程不安全:SimpleDateFormat内部维护日历状态(Calendar对象),多线程并发调用parse()方法会导致:

- 日期解析错误

- 报错

NumberFormatException - 甚至程序崩溃

2. 当前代码问题

1 | public void foo(SimpleDateFormat sdf) { |

例8:

1 | private static Integer i = 0; |

线程安全问题诊断

1. 核心隐患

-

Integer对象锁失效:i++操作实际会创建新的Integer对象,导致同步块锁对象变化

1

2

3synchronized(i) { // 当i++执行后,锁对象实际上已改变

i++; // 等价于 i = Integer.valueOf(i.intValue() + 1)

} -

典型执行序列:

- 线程A锁定Integer@1001(值为0)

- 线程B阻塞等待Integer@1001

- 线程A执行i++后锁变为Integer@1002(值为1)

- 线程B获得Integer@1001的锁(此时已过时)

2. 实际后果

- 最终结果可能小于10000(如9783等随机值)

- 未实现真正的原子性保护

3.4.4 练习

卖票练习

测试下面代码是否存在线程安全问题,并尝试改正

- 将sell方法声明为synchronized即可

- 注意只将对count进行修改的一行代码用synchronized括起来也不行。对count大小的判断也必须是为原子操作的一部分,否则也会导致count值异常。

1 | public class ExerciseSell { |

另外,用下面的代码行不行,为什么?

- 不行,因为sellCount会被多个线程共享,必须使用线程安全的实现类。

1 | List<Integer> sellCount = new ArrayList<>(); |

测试脚本

1 | for /L %n in (1,1,10) do java -cp ".;C:\Users\manyh\.m2\repository\ch\qos\logback\logback�classic\1.2.3\logback-classic-1.2.3.jar;C:\Users\manyh\.m2\repository\ch\qos\logback\logback�core\1.2.3\logback-core-1.2.3.jar;C:\Users\manyh\.m2\repository\org\slf4j\slf4j�api\1.7.25\slf4j-api-1.7.25.jar" cn.itcast.n4.exercise.ExerciseSell |

说明:

- 两段没有前后因果关系的临界区代码,只需要保证各自的原子性即可,不需要括起来。

转账练习

测试下面代码是否存在线程安全问题,并尝试改正

1 | public class ExerciseTransfer { |

这样改正行不行,为什么?

- 不行,因为不同线程调用此方法,将会锁住不同的对象

1 | public synchronized void transfer(Account target, int amount) { |

正确方案

- 将transfer方法的方法体用同步代码块包裹,将Account.class设为锁对象。

3.5 操作系统的管程(Monitor)

3.5.1 管程模型

管程(Monitor) 是一种用于实现进程/线程同步与互斥的高级编程抽象

1. 管程的核心特性

- 封装性:

管程将共享变量和对这些变量的操作(如入队、出队)封装为一个整体,外部只能通过管程提供的接口访问,避免了直接操作共享数据导致的竞态条件。 - 互斥性:

管程内部同一时间仅允许一个线程执行(隐式锁机制),其他线程需等待当前线程退出管程后才能进入。 - 条件变量(Condition Variables):

通过wait、signal(或notify)等操作实现线程间的协作。线程可在条件不满足时主动阻塞(wait),并由其他线程唤醒(signal)。

- 管程 vs 其他同步机制

| 机制 | 特点 |

|---|---|

| 管程 | 高层抽象,内置互斥和条件变量,代码更简洁(如 Java synchronized 块)。 |

| 信号量 | 更灵活(可跨多个函数),但需手动管理 P/V 操作,易出错。 |

| 自旋锁 | 忙等待,适用于短临界区,但浪费 CPU 资源。 |

管程是一种在信号量机制上进行改进的并发编程模型

3.5.2 ObjectMonitor

JVM 中的同步就是基于进入和退出管程(Monitor)对象实现的。每个对象实例都会有一个 Monitor,Monitor 可以和对象一起创建、销毁。Monitor 是由 ObjectMonitor 实现,而 ObjectMonitor 是由 C++ 的 ObjectMonitor.hpp 文件实现,如下所示:

1 | ObjectMonitor() { |

本文使用的是 Java 17,其中有 sun.jvm.hotspot.runtime.ObjectMonitor 类,这个类有如下的初始化方法:

1 | private static synchronized void initialize(TypeDataBase db) throws WrongTypeException { |

可以和 C++ 的 ObjectMonitor.hpp 的结构对应上,如果查看 initialize 方法的调用链,能够发现很多 JVM 的内部原理,本篇文章限于篇幅和内容原因,不去详细叙述了。

3.5.3 工作原理

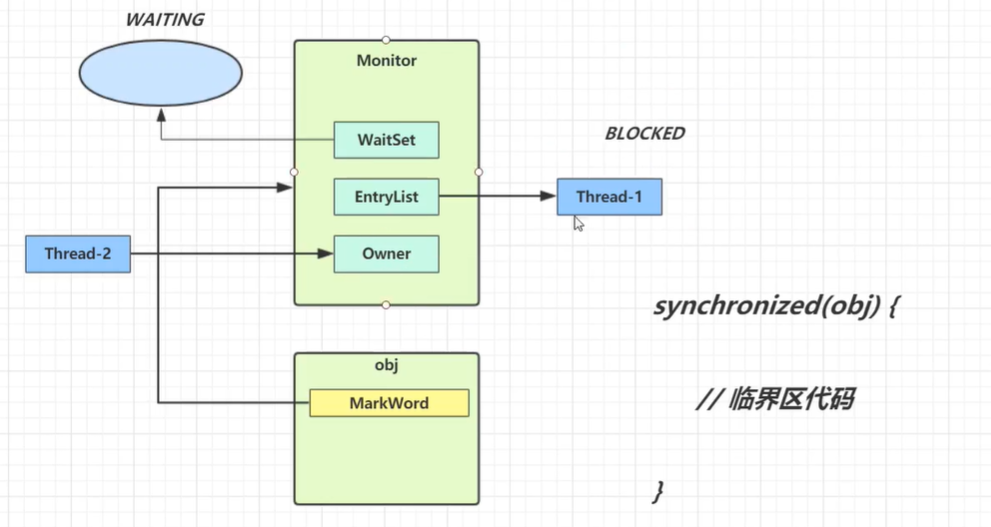

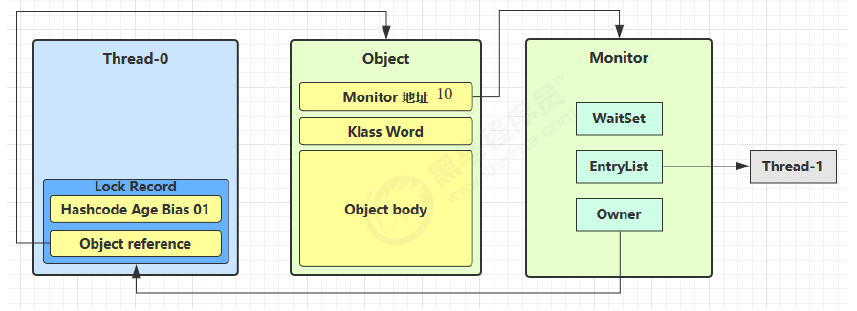

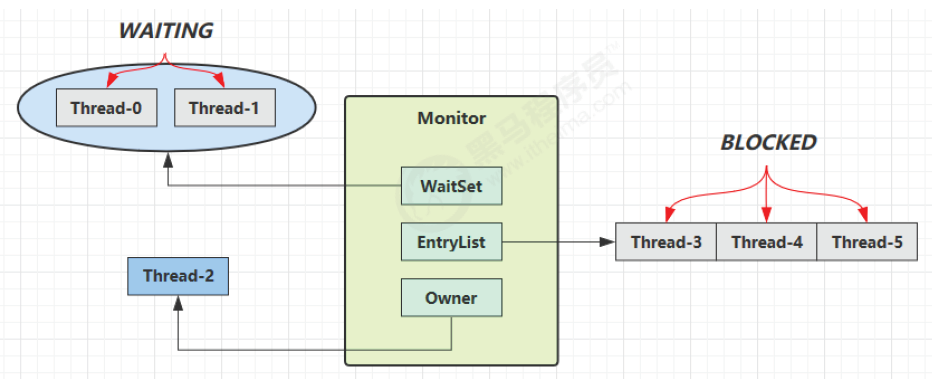

Monitor 被翻译为监视器或管程

每个 Java 对象都可以关联一个 Monitor 对象,Monitor 也是 class,其实例存储在堆中,如果使用 synchronized 给对象上锁(重量级)之后,该对象头的 Mark Word 中就被设置指向 Monitor 对象的指针

工作流程

- 当多个线程同时访问一段同步代码时,多个线程会先被存放在

EntryList集合中,处于 block 状态的线程,都会被加入到该列表。接下来当线程获取到对象的 Monitor时,Monitor 是依靠底层操作系统的Mutex Lock来实现互斥的,线程申请 Mutex 成功,则持有该 Mutex,其它线程将无法获取到该 Mutex。 - 当 Thread-2 执行 synchronized(obj) 就会将 Monitor 的所有者 Owner 置为 Thread-2,Monitor 中只能有一个 Owner,obj 对象的 Mark Word 指向 Monitor,把对象原有的 MarkWord 存入线程栈中的锁记录中(轻量级锁部分详解)

- 在 Thread-2 上锁的过程,Thread-3、Thread-4、Thread-5 也执行 synchronized(obj),就会进入 EntryList BLOCKED(双向链表)

- Thread-2 执行完同步代码块的内容,根据 obj 对象头中 Monitor 地址寻找,设置 Owner 为空,把线程栈的锁记录中的对象头的值设置回 MarkWord

- 唤醒 EntryList 中等待的线程来竞争锁,竞争是非公平的,如果这时有新的线程想要获取锁,可能直接就抢占到了,阻塞队列的线程就会继续阻塞

- WaitSet 中的 Thread-0,是以前获得过锁,但条件不满足进入 WAITING 状态的线程(wait-notify 机制)

Monitor 依赖于底层操作系统的实现,存在用户态和内核态的转换,增加了性能开销。

synchronized 必须是进入同一个对象的 Monitor 才有上述的效果

不加 synchronized 的对象不会关联监视器,不遵从以上规则

3.6 synchronized详解

3.6.1 Java对象的内存结构

- 对象头

- Mark Word

- Klass Pointer(类型指针)

- 指向对象所属类的元数据(即Class对象)

- 数组长度

- 实例数据

- 对齐填充

其中 Mark Word 记录了对象和锁有关的信息,在 64 位 JVM 中的长度是 64 位,具体信息如下图所示:

3.6.2 synchronized原理

1 | static final Object lock = new Object(); |

对应的字节码为

1 | public static void main(java.lang.String[]); |

monitorenter

官方的定义:

主要的意思是说:

每个对象都与一个 monitor 相关联。当且仅当 monitor 对象有一个所有者时才会被锁定。执行 monitorenter 的线程试图获得与 objectref 关联的 monitor 的所有权,如下所示:

- 若与 objectref 相关联的 monitor 计数为 0,线程进入 monitor 并设置 monitor 计数为 1,这个线程成为这个 monitor 的拥有者。

- 如果该线程已经拥有与 objectref 关联的 monitor,则该线程重新进入 monitor,并增加 monitor 的计数。

- 如果另一个线程已经拥有与 objectref 关联的 monitor,则该线程将阻塞,直到 monitor 的计数为零,该线程才会再次尝试获得 monitor 的所有权。

monitorexit

官方的定义:

主要的意思是说:

- 执行 monitorexit 的线程必须是与 objectref 引用的实例相关联的 monitor 的所有者。

- 线程将与 objectref 关联的 monitor 计数减一。如果计数为 0,则线程退出并释放这个 monitor。其他因为该 monitor 阻塞的线程可以尝试获取该 monitor。

3.6.3 锁的发展过程

在 JDK 1.5 之前,Java 是依靠 Synchronized 关键字实现锁功能来做到这点的。Synchronized 是 JVM 实现的一种内置锁,锁的获取和释放是由 JVM 隐式实现。

到了 JDK 1.5 版本,并发包中新增了 Lock 接口来实现锁功能,它提供了与Synchronized 关键字类似的同步功能,只是在使用时需要显示获取和释放锁。

Lock 同步锁是基于 Java 实现的,而 Synchronized 是基于底层操作系统的 Mutex Lock 实现,每次获取和释放锁操作都会带来用户态和内核态的切换,从而增加系统性能开销。因此,在锁竞争激烈的情况下,Synchronized同步锁在性能上就表现得非常糟糕,它也常被大家称为重量级锁。

特别是在单个线程重复申请锁的情况下,JDK1.5 版本的 Synchronized 锁性能要比 Lock 的性能差很多。

到了 JDK 1.6 版本之后,Java 对 Synchronized 同步锁做了充分的优化,甚至在某些场景下,它的性能已经超越了 Lock 同步锁。

3.6.4 锁升级过程

synchronized 是可重入、不公平的重量级锁,所以可以对其进行优化

无锁 -> 偏向锁 -> 轻量级锁 -> 重量级锁 // 随着竞争的增加,只能锁升级,不能降级

3.6.5 偏向锁

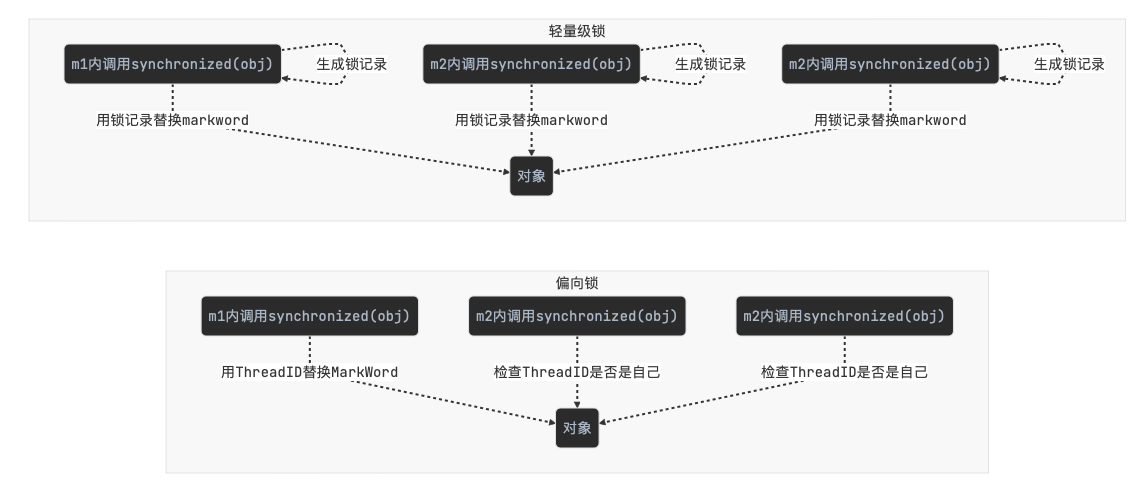

偏向锁的思想是偏向于让第一个获取锁对象的线程使用,这个线程之后重新获取该锁不再需要同步操作:

- 当锁对象第一次被线程获得的时候进入偏向状态,标记为 101,同时

使用 CAS 操作将线程 ID 记录到 Mark Word。如果 CAS 操作成功,这个线程以后进入这个锁相关的同步块,查看这个线程 ID 是自己的就表示没有竞争,就不需要再进行任何同步操作

例如:

1 | static final Object obj = new Object(); |

偏向状态

回忆一下对象头格式

一个对象创建时:

-

如果开启了偏向锁(默认开启),那么对象创建后,MarkWord 值为 0x05 即最后 3 位为 101,thread、epoch、age 都为 0

-

偏向锁是默认是延迟的,不会在程序启动时立即生效,如果想避免延迟,可以加 VM 参数

-XX:BiasedLockingStartupDelay=0来禁用延迟。JDK 8 延迟 4s 开启偏向锁原因:在刚开始执行代码时,会有好多线程来抢锁,如果开偏向锁效率反而降低 -

当一个对象已经计算过 hashCode,就再也无法进入偏向状态了

-

添加 VM 参数

-XX:-UseBiasedLocking禁用偏向锁 -

当有另外一个线程去尝试获取这个锁对象时,偏向状态就宣告结束,此时撤销偏向(Revoke Bias)后恢复到未锁定或轻量级锁状态

1)测试延迟特性

2)测试偏向锁

利用 jol 第三方工具来查看对象头信息

1 | // 添加虚拟机参数 -XX:BiasedLockingStartupDelay=0 |

1 | 11:08:58.117 c.TestBiased [t1] - synchronized 前 |

处于偏向锁的对象解锁后,线程 id 仍存储于对象头中

3)测试禁用

在上面测试代码运行时在添加 VM 参数 -XX:-UseBiasedLocking 禁用偏向锁

输出

1 | 11:13:10.018 c.TestBiased [t1] - synchronized 前 |

4)测试 hashCode

- 正常状态对象一开始是没有 hashCode 的,第一次调用才生成

撤销偏向锁的状态

- 调用对象的 hashCode

调用了对象的 hashCode,但偏向锁的对象 MarkWord 中存储的是线程 id,如果调用 hashCode 会导致偏向锁被撤销

- 轻量级锁会在锁记录中记录 hashCode

- 重量级锁会在 Monitor 中记录 hashCode

在调用 hashCode 后使用偏向锁,记得去掉-XX:-UseBiasedLocking

输出

1 | 11:22:10.386 c.TestBiased [main] - 调用 hashCode:1778535015 |

- 有其它线程使用偏向锁对象

当有其它线程使用偏向锁对象时,会将偏向锁升级为轻量级锁

1 | private static void test2() throws InterruptedException { |

输出

1 | [t1] - 00000000 00000000 00000000 00000000 00011111 01000001 00010000 00000101 |

- 调用 wait/notify,需要申请 Monitor,进入 WaitSet

1 | public static void main(String[] args) throws InterruptedException { |

输出

1 | [t1] - 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000101 |

批量重偏向

如果对象虽然被多个线程访问,但没有竞争,这时偏向了线程 T1 的对象仍有机会重新偏向 T2,重偏向会重置对象 的 Thread ID

当撤销偏向锁阈值超过 20 次后,jvm 会这样觉得,我是不是偏向错了呢,于是会在给这些对象加锁时重新偏向至 加锁线程

1 | private static void test3() throws InterruptedException { |

输出

1 | [t1] - 0 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 |

批量撤销

当撤销偏向锁阈值超过 40 次后,jvm 会觉得自己确实偏向错了,根本就不该偏向。于是整个类的所有对象 都会变为不可偏向的,新建的对象也是不可偏向的

1 | static Thread t1,t2,t3; |

JDK 15 废弃偏向锁

官方的详细说明JEP 374: Disable and Deprecate Biased Locking

当时为什么要引入偏向锁?

在过去,Java应用通常使用的都是HashTable、Vector等比较老的集合库,这类集合库大量使用了 synchronized来保证线程安全。所以偏向锁技术作为synchronized的一种优化手段,可以减少无锁竞争情况下的 开销,通过假定一个锁一直由同一线程拥有,从而避免执行比较和交换的原子操作。从历史上看,偏向锁使得 JVM 的性能得到了显著改善。

现在为什么又要废弃偏向锁?

但是,偏向锁的局限是当只有一个线程反复进入同步代码块时才能快速获得,但是当有其他线程尝试获取锁的时 候,就需要等到safepoint时,再将偏向锁撤销为无锁的状态或者升级为轻量级锁,而这个过程其实是会消耗一 定的性能的。

在高并发的场景下,频繁的撤销偏向锁和重新偏向不仅不能提升性能,还会导致性能下降,特别是在那些锁竞争较为激烈的应用中。

并且,随着Java应用程序的发展和优化,过去能够从偏向锁中获得的性能提升在当今的应用中不再明显。许多现代应用程序使用了不需要同步的集合类或更高性能的并发数据结构(如ConcurrentHashMap、CopyOnWriteArrayList等),而不再频繁地执行无争用的同步(synchronized)操作。

还有就是官方在文档中提到的,偏向锁的引入导致代码很复杂,给HotSpot虚拟机中锁相关部分与其他组件之间的交互也带来了复杂性。这种复杂性使得理解代码的各个部分变得困难,并且阻碍了在同步子系统内进行重大设计更改。因此,废弃偏向锁有助于减少复杂性,使代码更容易维护和改进。

总之,废弃偏向锁是为了减少复杂性、提高代码可维护性,并鼓励开发人员采用更现代的并发编程技术,以适应当今Java应用程序的性能需求。

参考资料

https://github.com/farmerjohngit/myblog/issues/12

https://www.cnblogs.com/LemonFive/p/11246086.html

https://www.cnblogs.com/LemonFive/p/11248248.html

3.6.6 轻量级锁

使用场景:有多个线程对同一个对象加锁,但加锁的时间是错开的(没有竞争),可以使用轻量级锁来优化,轻量级锁对使用者是透明的(不可见)

可重入锁:线程可以进入任何一个它已经拥有的锁所同步着的代码块,可重入锁最大的作用是避免死锁

轻量级锁在没有竞争时(锁重入时),每次重入仍然需要执行 CAS 操作,Java 6 才引入的偏向锁来优化

锁重入实例:假设有两个方法同步块,利用同一个对象加锁

1 | static final Object obj = new Object(); |

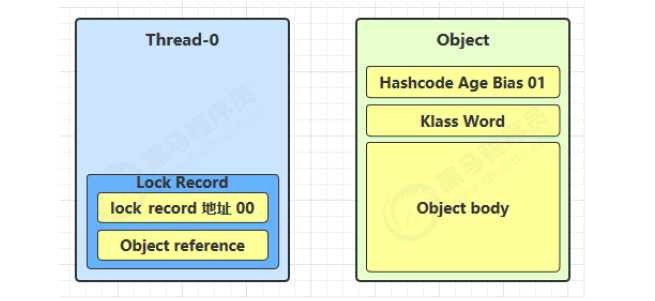

-

创建锁记录(Lock Record)对象,每个线程的栈帧都会包含一个锁记录的结构,存储锁定对象的 Mark Word

-

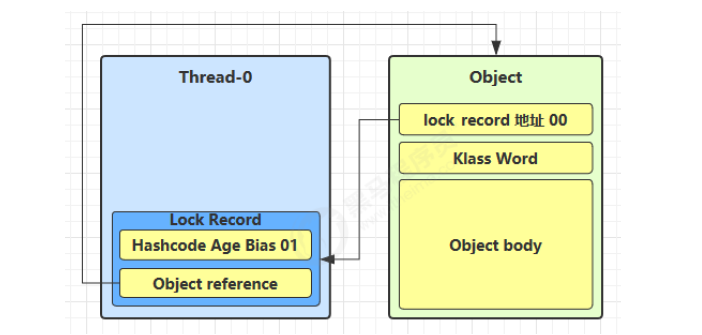

让锁记录中 Object reference 指向锁住的对象,并尝试用 CAS 替换 Object 的 Mark Word,将 Mark Word 的值存入锁记录

-

如果 CAS 替换成功,对象头中存储了锁记录地址和状态 00(轻量级锁),表示由该线程给对象加锁

-

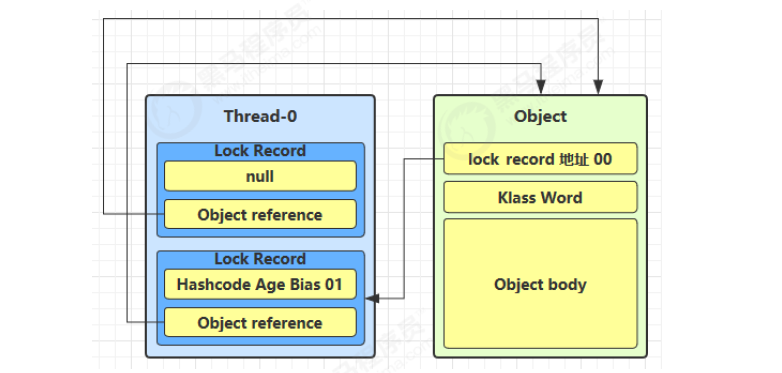

如果 CAS 失败,有两种情况:

- 如果是其它线程已经持有了该 Object 的轻量级锁,这时表明有竞争,进入锁膨胀过程

- 如果是线程自己执行了 synchronized 锁重入,就添加一条 Lock Record 作为重入的计数

-

当退出 synchronized 代码块(解锁时)

- 如果有取值为 null 的锁记录,表示有重入,这时重置锁记录,表示重入计数减 1

- 如果锁记录的值不为 null,这时使用 CAS 将 Mark Word 的值恢复给对象头

- 成功,则解锁成功

- 失败,说明轻量级锁进行了锁膨胀或已经升级为重量级锁,进入重量级锁解锁流程

3.6.7 锁膨胀

在尝试加轻量级锁的过程中,CAS 操作无法成功,可能是其它线程为此对象加上了轻量级锁(有竞争),这时需要进行锁膨胀,将轻量级锁变为重量级锁

-

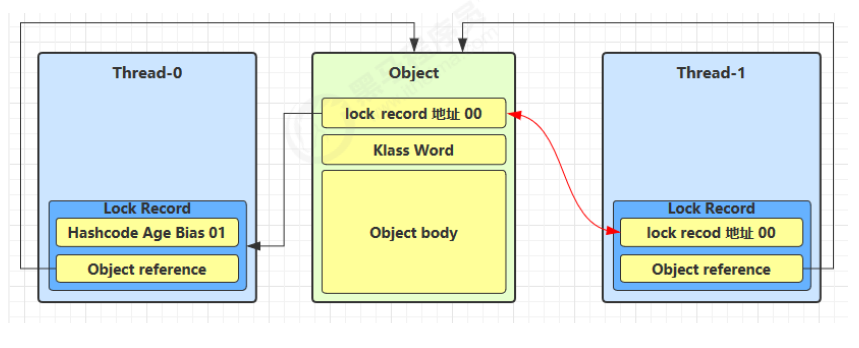

当 Thread-1 进行轻量级加锁时,Thread-0 已经对该对象加了轻量级锁

-

Thread-1 加轻量级锁失败,进入锁膨胀流程:

-

为 Object 对象申请 Monitor 锁,通过 Object 对象头获取到持锁线程,将 Monitor 的 Owner 置为 Thread-0,将 Object 的对象头指向重量级锁地址

-

然后自己进入 Monitor 的 EntryList BLOCKED

-

-

当 Thread-0 退出同步块解锁时,使用 CAS 将 Mark Word 的值恢复给对象头失败,这时进入重量级解锁流程,即按照 Monitor 地址找到 Monitor 对象,设置 Owner 为 null,唤醒 EntryList 中 BLOCKED 线程

3.7 锁优化

3.7.1 自旋锁

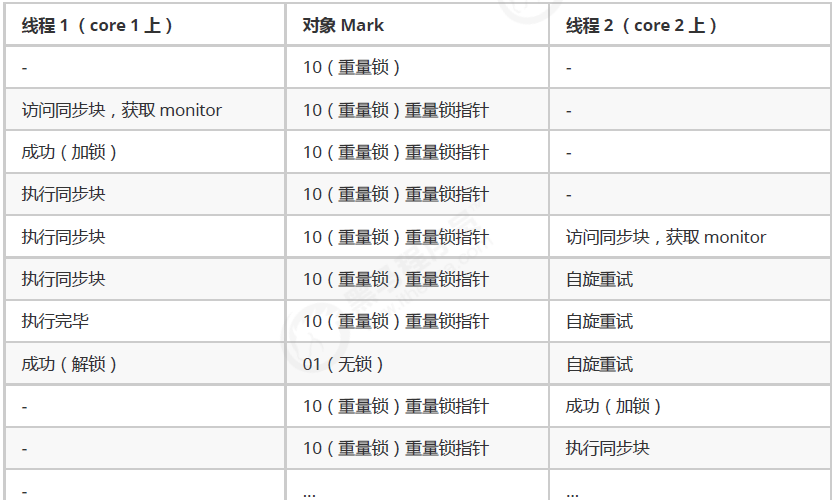

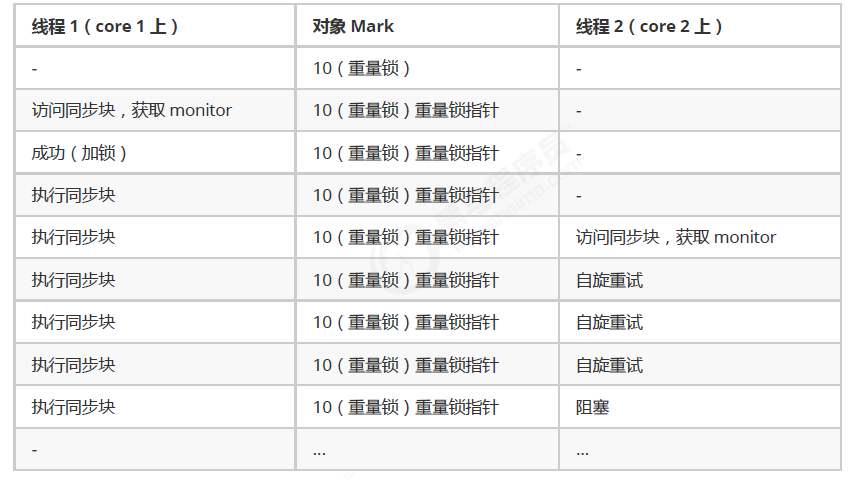

重量级锁竞争时,尝试获取锁的线程不会立即阻塞,可以使用自旋(默认 10 次)来进行优化,采用循环的方式去尝试获取锁

注意:

- 自旋占用 CPU 时间,单核 CPU 自旋就是浪费时间,因为同一时刻只能运行一个线程,多核 CPU 自旋才能发挥优势

- 自旋失败的线程会进入阻塞状态

优点:不会立即进入阻塞状态,减少线程上下文切换的消耗

缺点:当自旋的线程越来越多时,会不断的消耗 CPU 资源

自旋锁情况:

-

自旋成功的情况:

-

自旋失败的情况:

自旋锁说明:

- 在 Java 6 之后自旋锁是自适应的,比如对象刚刚的一次自旋操作成功过,那么认为这次自旋成功的可能性会高,就多自旋几次;反之,就少自旋甚至不自旋,比较智能

- Java 7 之后不能控制是否开启自旋功能,由 JVM 控制

1 | //手写自旋锁 |

3.7.2 锁消除

锁消除是指对于被检测出不可能存在竞争的共享数据的锁进行消除,这是 JVM 即时编译器的优化

锁消除主要是通过逃逸分析来支持,如果堆上的共享数据不可能逃逸出去被其它线程访问到,那么就可以把它们当成私有数据对待,也就可以将它们的锁进行消除(同步消除:JVM 逃逸分析)

1 |

|

java -jar benchmarks.jar

Benchmark Mode Samples Score Score error Units c.i.MyBenchmark.a avgt 5 1.542 0.056 ns/op c.i.MyBenchmark.b avgt 5 1.518 0.091 ns/op

java -XX:-EliminateLocks -jar benchmarks.jar

Benchmark Mode Samples Score Score error Units c.i.MyBenchmark.a avgt 5 1.507 0.108 ns/op c.i.MyBenchmark.b avgt 5 16.976 1.572 ns/op

3.7.3 锁粗化

对相同对象多次加锁,导致线程发生多次重入,频繁的加锁操作就会导致性能损耗,可以使用锁粗化方式优化

如果虚拟机探测到一串的操作都对同一个对象加锁,将会把加锁的范围扩展(粗化)到整个操作序列的外部

-

一些看起来没有加锁的代码,其实隐式的加了很多锁:

1

2

3public static String concatString(String s1, String s2, String s3) {

return s1 + s2 + s3;

} -

String 是一个不可变的类,编译器会对 String 的拼接自动优化。在 JDK 1.5 之前,转化为 StringBuffer 对象的连续 append() 操作,每个 append() 方法中都有一个同步块

1

2

3

4

5

6

7public static String concatString(String s1, String s2, String s3) {

StringBuffer sb = new StringBuffer();

sb.append(s1);

sb.append(s2);

sb.append(s3);

return sb.toString();

}

扩展到第一个 append() 操作之前直至最后一个 append() 操作之后,只需要加锁一次就可以

3.8 wait & notify

3.8.1 基本使用

obj.wait()让进入 object 监视器的线程到 waitSet 等待obj.notify()在 object 上正在 waitSet 等待的线程中挑一个唤醒obj.notifyAll()让 object 上正在 waitSet 等待的线程全部唤醒

它们都是线程之间进行协作的手段,都属于 Object 对象的方法。必须获得此对象的锁,才能调用这几个方法

1 | final static Object obj = new Object(); |

notify 的一种结果

20:00:53.096 [Thread-0] c.TestWaitNotify - 执行.... 20:00:53.099 [Thread-1] c.TestWaitNotify - 执行.... 20:00:55.096 [main] c.TestWaitNotify - 唤醒 obj 上其它线程 20:00:55.096 [Thread-0] c.TestWaitNotify - 其它代码....

notifyAll 的结果

19:58:15.457 [Thread-0] c.TestWaitNotify - 执行.... 19:58:15.460 [Thread-1] c.TestWaitNotify - 执行.... 19:58:17.456 [main] c.TestWaitNotify - 唤醒 obj 上其它线程 19:58:17.456 [Thread-1] c.TestWaitNotify - 其它代码.... 19:58:17.456 [Thread-0] c.TestWaitNotify - 其它代码....

wait() 方法会释放对象的锁,进入 WaitSet 等待区,无限制等待,直到 notify 为止,从而让其他线程有机会获取对象的锁。

wait(long n) 有时限的等待, 到 n 毫秒后结束等待,或是被 notify

sleep(long n) 和 wait(long n)的区别?

- sleep 是 Thread 方法,而 wait 是 Object 的方法

- sleep 不需要强制和 synchronized 配合使用,但 wait 需要 和 synchronized 一起用

- sleep 在睡眠的同时,不会释放对象锁的,但 wait 在等待的时候会释放对象锁

- 它们 状态 TIMED_WAITING

step 1

1 | static final Object room = new Object(); |

思考下面的解决方案好不好,为什么?

1 | new Thread(() -> { |

输出

20:49:49.883 [小南] c.TestCorrectPosture - 有烟没?[false] 20:49:49.887 [小南] c.TestCorrectPosture - 没烟,先歇会! 20:49:50.882 [送烟的] c.TestCorrectPosture - 烟到了噢! 20:49:51.887 [小南] c.TestCorrectPosture - 有烟没?[true] 20:49:51.887 [小南] c.TestCorrectPosture - 可以开始干活了 20:49:51.887 [其它人] c.TestCorrectPosture - 可以开始干活了 20:49:51.887 [其它人] c.TestCorrectPosture - 可以开始干活了 20:49:51.888 [其它人] c.TestCorrectPosture - 可以开始干活了 20:49:51.888 [其它人] c.TestCorrectPosture - 可以开始干活了 20:49:51.888 [其它人] c.TestCorrectPosture - 可以开始干活了

- 其它干活的线程,都要一直阻塞,效率太低

- 小南线程必须睡足 2s 后才能醒来,就算烟提前送到,也无法立刻醒来

- 加了 synchronized (room) 后,就好比小南在里面反锁了门睡觉,烟根本没法送进门,main 没加 synchronized 就好像 main 线程是翻窗户进来的

- 解决方法,使用 wait - notify 机制

step 2

思考下面的实现行吗,为什么?

1 | new Thread(() -> { |

- 解决了其它干活的线程阻塞的问题

- 但如果有其它线程也在等待条件呢?

step 3

1 | new Thread(() -> { |

输出

20:53:12.173 [小南] c.TestCorrectPosture - 有烟没?[false] 20:53:12.176 [小南] c.TestCorrectPosture - 没烟,先歇会! 20:53:12.176 [小女] c.TestCorrectPosture - 外卖送到没?[false] 20:53:12.176 [小女] c.TestCorrectPosture - 没外卖,先歇会! 20:53:13.174 [送外卖的] c.TestCorrectPosture - 外卖到了噢! 20:53:13.174 [小南] c.TestCorrectPosture - 有烟没?[false] 20:53:13.174 [小南] c.TestCorrectPosture - 没干成活...

- notify 只能随机唤醒一个 WaitSet 中的线程,这时如果有其它线程也在等待,那么就可能唤醒不了正确的线程,称之为【虚假唤醒】

- 解决方法,改为 notifyAll

step 4

1 | new Thread(() -> { |

输出

20:55:23.978 [小南] c.TestCorrectPosture - 有烟没?[false] 20:55:23.982 [小南] c.TestCorrectPosture - 没烟,先歇会! 20:55:23.982 [小女] c.TestCorrectPosture - 外卖送到没?[false] 20:55:23.982 [小女] c.TestCorrectPosture - 没外卖,先歇会! 20:55:24.979 [送外卖的] c.TestCorrectPosture - 外卖到了噢! 20:55:24.979 [小女] c.TestCorrectPosture - 外卖送到没?[true] 20:55:24.980 [小女] c.TestCorrectPosture - 可以开始干活了 20:55:24.980 [小南] c.TestCorrectPosture - 有烟没?[false] 20:55:24.980 [小南] c.TestCorrectPosture - 没干成活...

- 用 notifyAll 仅解决某个线程的唤醒问题,但使用 if + wait 判断仅有一次机会,一旦条件不成立,就没有重新判断的机会了

- 解决方法,用 while + wait,当条件不成立,再次 wait

step 5

将 if 改为 while

1 | if (!hasCigarette) { |

改动后

1 | while (!hasCigarette) { |

输出

20:58:34.322 [小南] c.TestCorrectPosture - 有烟没?[false] 20:58:34.326 [小南] c.TestCorrectPosture - 没烟,先歇会! 20:58:34.326 [小女] c.TestCorrectPosture - 外卖送到没?[false] 20:58:34.326 [小女] c.TestCorrectPosture - 没外卖,先歇会! 20:58:35.323 [送外卖的] c.TestCorrectPosture - 外卖到了噢! 20:58:35.324 [小女] c.TestCorrectPosture - 外卖送到没?[true] 20:58:35.324 [小女] c.TestCorrectPosture - 可以开始干活了 20:58:35.324 [小南] c.TestCorrectPosture - 没烟,先歇会!

正确使用wait-notify套路总结

1 | synchronized(lock) { |

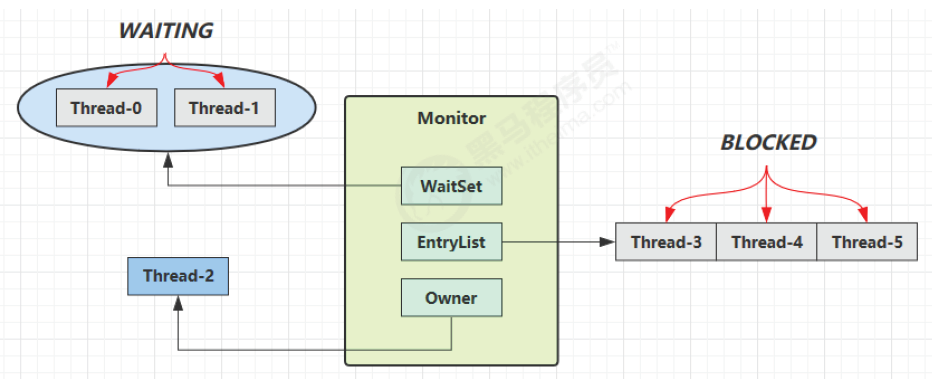

3.8.2 原理

- Owner 线程发现条件不满足,调用 wait 方法,即可进入 WaitSet 变为 WAITING 状态

- BLOCKED 和 WAITING 的线程都处于阻塞状态,不占用 CPU 时间片

- BLOCKED 线程会在 Owner 线程释放锁时唤醒

- WAITING 线程会在 Owner 线程调用 notify 或 notifyAll 时唤醒,唤醒后并不意味者立刻获得锁,需要进入 EntryList 重新竞争

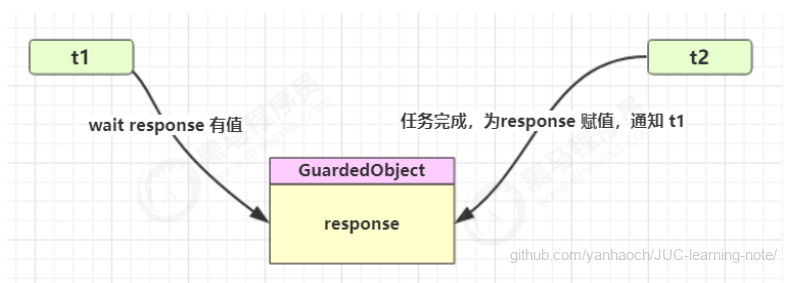

*同步模式之保护性暂停

- 定义

即 Guarded Suspension,用在一个线程等待另一个线程的执行结果

要点

- 有一个结果需要从一个线程传递到另一个线程,让他们关联同一个 GuardedObject

- 如果有结果不断从一个线程到另一个线程那么可以使用消息队列(见生产者/消费者)

- JDK 中,join 的实现、Future 的实现,采用的就是此模式

- 因为要等待另一方的结果,因此归类到同步模式

- 实现

1 | class GuardedObject { |

测试 一个线程等待另一个线程的执行结果

1 | public static void main(String[] args) { |

执行结果

20:19:47.513 [main] INFO com.lxd.juc.GuardedObject -- 等待结果... 20:19:50.515 [Thread-0] INFO com.lxd.juc.GuardedObject -- download complete... 20:19:50.515 [main] INFO com.lxd.juc.GuardedObject -- OK

- 带超时版GuardedObject

如果要控制超时时间呢

1 |

|

测试 没有超时

1 | public static void main(String[] args) { |

输出

21:02:30.373 [main] INFO com.lxd.juc.GuardedObjectV2 -- 等待结果... 21:02:30.374 [main] INFO com.lxd.juc.GuardedObjectV2 -- waitTime: 4000 21:02:33.378 [t1] INFO com.lxd.juc.GuardedObjectV2 -- download complete... 21:02:33.378 [t1] INFO com.lxd.juc.GuardedObjectV2 -- send notify... 21:02:33.379 [main] INFO com.lxd.juc.GuardedObjectV2 -- passTime:【3005】,result is null ?【false】 21:02:33.379 [main] INFO com.lxd.juc.GuardedObjectV2 -- result -> OK

测试超时

1 | // 等待时间不足 |

输出

21:02:56.988 [main] INFO com.lxd.juc.GuardedObjectV2 -- 等待结果... 21:02:56.989 [main] INFO com.lxd.juc.GuardedObjectV2 -- waitTime: 2000 21:02:58.994 [main] INFO com.lxd.juc.GuardedObjectV2 -- passTime:【2005】,result is null ?【true】 21:02:58.996 [main] INFO com.lxd.juc.GuardedObjectV2 -- waitTime: -5 21:02:58.996 [main] INFO com.lxd.juc.GuardedObjectV2 -- 等待超时 break... 21:02:58.996 [main] INFO com.lxd.juc.GuardedObjectV2 -- result -> null 21:02:59.992 [t1] INFO com.lxd.juc.GuardedObjectV2 -- download complete... 21:02:59.992 [t1] INFO com.lxd.juc.GuardedObjectV2 -- send notify...

*join原理

1 | //不带参 |

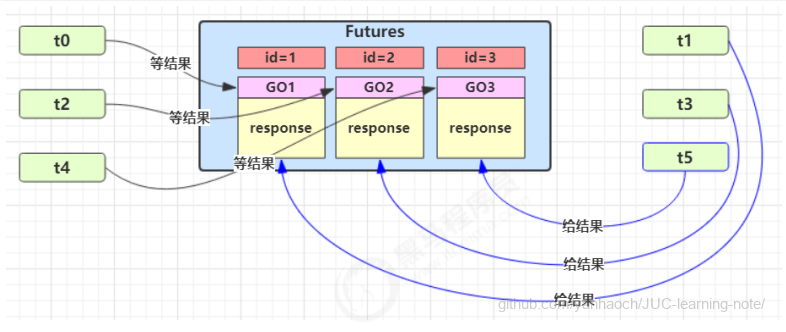

- 多任务版GuardedObject

图中 Futures 就好比居民楼一层的信箱(每个信箱有房间编号),左侧的 t0,t2,t4 就好比等待邮件的居民,右侧的 t1,t3,t5 就好比邮递员 。

如果需要在多个类之间使用 GuardedObject 对象,作为参数传递不是很方便,因此设计一个用来解耦的中间类, 这样不仅能够解耦【结果等待者】和【结果生产者】,还能够同时支持多个任务的管理。

新增 id 用来标识 Guarded Object

1 | static class GuardedObject { |

中间解耦类

1 | static class MailBoxes { |

业务相关类

1 | static class Person extends Thread { |

测试

1 | public static void main(String[] args) throws InterruptedException { |

某次运行结果

22:05:14.688 [Thread-1] INFO com.lxd.juc.Test1 -- 开始收信 id:2 22:05:14.688 [Thread-0] INFO com.lxd.juc.Test1 -- 开始收信 id:1 22:05:14.688 [Thread-2] INFO com.lxd.juc.Test1 -- 开始收信 id:3 22:05:15.691 [Thread-5] INFO com.lxd.juc.Test1 -- 送信 id:1, 内容:内容1 22:05:15.691 [Thread-4] INFO com.lxd.juc.Test1 -- 送信 id:2, 内容:内容2 22:05:15.691 [Thread-3] INFO com.lxd.juc.Test1 -- 送信 id:3, 内容:内容3 22:05:15.691 [Thread-1] INFO com.lxd.juc.Test1 -- 收到信 id:2,内容:内容2 22:05:15.691 [Thread-0] INFO com.lxd.juc.Test1 -- 收到信 id:1,内容:内容1 22:05:15.691 [Thread-2] INFO com.lxd.juc.Test1 -- 收到信 id:3,内容:内容3

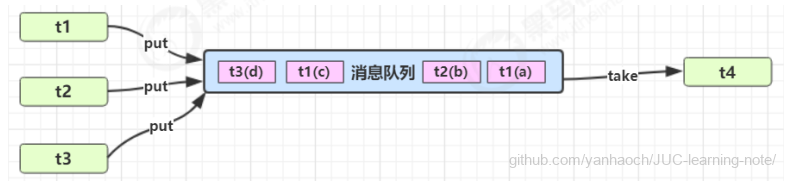

∗异步模式之生产者消费者

- 定义

要点

- 与前面的保护性暂停中的 GuardObject 不同,不需要产生结果和消费结果的线程一一对应

- 消费队列可以用来平衡生产和消费的线程资源

- 生产者仅负责产生结果数据,不关心数据该如何处理,而消费者专心处理结果数据

- 消息队列是有容量限制的,满时不会再加入数据,空时不会再消耗数据

- JDK 中各种阻塞队列,采用的就是这种模式

- 实现

1 |

|

测试

1 | public static void main(String[] args) { |

某次运行结果

22:43:01.547 [生产者线程0] INFO com.lxd.juc.Test21 -- 生产者线程已添加元素:Msg{id=0, msg=消息0}

22:43:01.551 [生产者线程1] INFO com.lxd.juc.Test21 -- 生产者线程已添加元素:Msg{id=1, msg=消息1}

22:43:01.552 [生产者线程2] INFO com.lxd.juc.Test21 -- 队列已满,生产者线程等待...

22:43:02.552 [消费者线程] INFO com.lxd.juc.Test21 -- 消费者线程拿到消息:Msg{id=0, msg=消息0}

22:43:02.553 [生产者线程2] INFO com.lxd.juc.Test21 -- 生产者线程已添加元素:Msg{id=2, msg=消息2}

22:43:03.558 [消费者线程] INFO com.lxd.juc.Test21 -- 消费者线程拿到消息:Msg{id=1, msg=消息1}

22:43:04.561 [消费者线程] INFO com.lxd.juc.Test21 -- 消费者线程拿到消息:Msg{id=2, msg=消息2}

22:43:05.566 [消费者线程] INFO com.lxd.juc.Test21 -- 队列为空,消费者线程等待...

3.9 park & unpark

3.9.1 基本使用

它们是 LockSupport 类中的方法

1 | // 暂停当前线程 |

1 | public static void main(String[] args) throws InterruptedException { |

输出

23:26:53.697 [t1] INFO com.lxd.juc.Test21 -- start... 23:26:54.701 [t1] INFO com.lxd.juc.Test21 -- park... 23:26:55.698 [main] INFO com.lxd.juc.Test21 -- unpark... 23:26:55.698 [t1] INFO com.lxd.juc.Test21 -- resume...

先 unpark 再 park

1 | public static void main(String[] args) throws InterruptedException { |

输出

23:28:58.580 [t1] INFO com.lxd.juc.Test21 -- start... 23:28:59.582 [main] INFO com.lxd.juc.Test21 -- unpark... 23:29:00.582 [t1] INFO com.lxd.juc.Test21 -- park... 23:29:00.583 [t1] INFO com.lxd.juc.Test21 -- resume...

特点

LockSupport 出现就是为了增强 wait & notify 的功能

与 Object 的 wait & notify 相比

- wait,notify 和 notifyAll 必须配合 Object Monitor 一起使用,而 park、unpark 不需要

- park & unpark 以线程为单位来阻塞和唤醒线程,而 notify 只能随机唤醒一个等待线程,notifyAll 是唤醒所有等待线程

- park & unpark 可以先 unpark,而 wait & notify 不能先 notify。类比生产消费,先消费发现有产品就消费,没有就等待;先生产就直接产生商品,然后线程直接消费

- wait 会释放锁资源进入等待队列,park 不会释放锁资源,只负责阻塞当前线程,会释放 CPU

3.9.2 原理

每个线程都有自己的一个 Parker 对象(由C++编写,java中不可见),由三部分组成 _counter, _cond和 _mutex 打个比喻

- 线程就像一个旅人,Parker 就像他随身携带的背包,条件变量就好比背包中的帐篷。_counter 就好比背包中 的备用干粮(0 为耗尽,1 为充足)

- 调用 park 就是要看需不需要停下来歇息

- 如果备用干粮耗尽,那么钻进帐篷歇息

- 如果备用干粮充足,那么不需停留,继续前进

- 调用 unpark,就好比令干粮充足

- 如果这时线程还在帐篷,就唤醒让他继续前进

- 如果这时线程还在运行,那么下次他调用 park 时,仅是消耗掉备用干粮,不需停留继续前进

- 因为背包空间有限,多次调用 unpark 仅会补充一份备用干粮

场景一

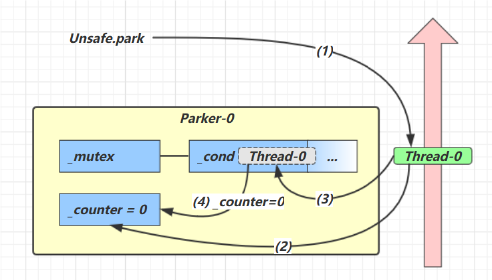

- 当前线程调用 Unsafe.park() 方法

- 检查 _counter ,本情况为 0,这时获得 _mutex 互斥锁

- 线程进入 _cond 条件变量阻塞

- 设置 _counter = 0

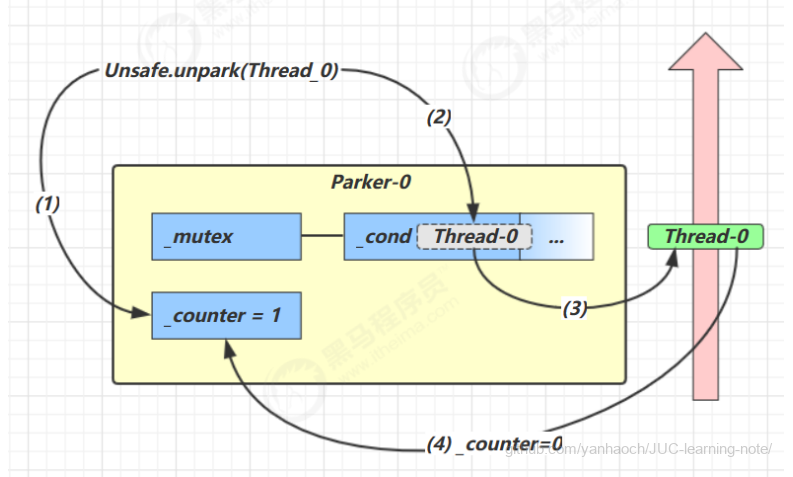

场景二

- 调用 Unsafe.unpark(Thread_0) 方法,设置 _counter 为 1

- 唤醒 _cond 条件变量中的 Thread_0

- Thread_0 恢复运行

- 设置 _counter 为 0

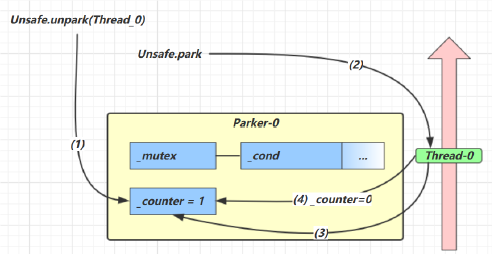

场景三

- 调用 Unsafe.unpark(Thread_0) 方法,设置 _counter 为 1

- 当前线程调用 Unsafe.park() 方法

- 检查 _counter ,本情况为 1,这时线程无需阻塞,继续运行

- 设置 _counter 为 0

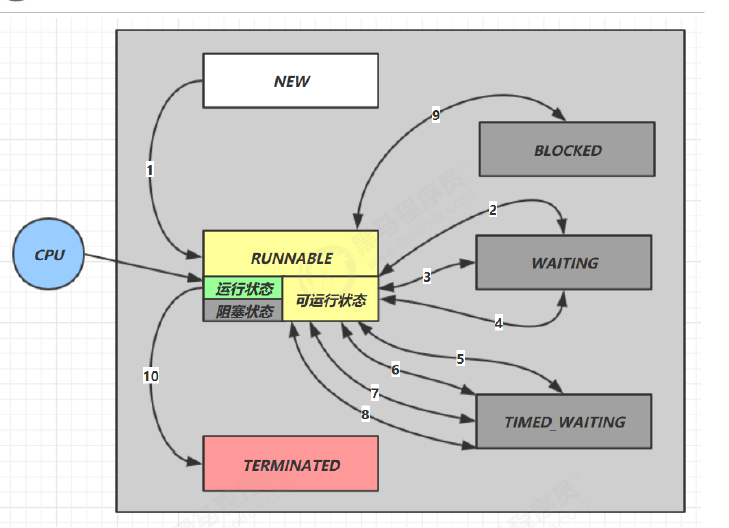

3.10 重新理解线程状态转换

假设有线程 Thread t

1️⃣ NEW --> RUNNABLE

- 当调用

t.start()方法时,由NEW --> RUNNABLE

2️⃣ RUNNABLE <--> WAITING

t 线程用 synchronized(obj) 获取了对象锁后

- 调用

obj.wait()方法时,t 线程从RUNNABLE --> WAITING - 调用

obj.notify(),obj.notifyAll(),t.interrupt()时- 竞争锁成功,t 线程从

WAITING --> RUNNABLE - 竞争锁失败,t 线程从

WAITING --> BLOCKED

- 竞争锁成功,t 线程从

1 | public class TestWaitNotify { |

3️⃣ RUNNABLE <--> WAITING

- 当前线程调用

t.join()方法时,当前线程从RUNNABLE --> WAITING注意是当前线程在t 线程对象的监视器上等待 - t 线程运行结束,或调用了当前线程的

interrupt()时,当前线程从WAITING --> RUNNABLE

4️⃣ RUNNABLE <--> WAITING

- 当前线程调用

LockSupport.park()方法会让当前线程从RUNNABLE --> WAITING - 调用

LockSupport.unpark(目标线程) 或调用了线程 的interrupt(),会让目标线程从WAITING --> RUNNABLE

5️⃣ RUNNABLE <--> TIMED_WAITING

t 线程用 synchronized(obj) 获取了对象锁后

- 调用

obj.wait(long n)方法时,t 线程从RUNNABLE --> TIMED_WAITING - t线程等待时间超过了 n 毫秒,或调用

obj.notify(),obj.notifyAll(),t.interrupt()时- 竞争锁成功,t 线程从

TIMED_WAITING --> RUNNABLE - 竞争锁失败,t 线程从

TIMED_WAITING --> BLOCKED

- 竞争锁成功,t 线程从

6️⃣ RUNNABLE <--> TIMED_WAITING

- 当前线程调用

t.join(long n)方法时,当前线程从RUNNABLE --> TIMED_WAITING注意是当前线程在t 线程对象的监视器上等待 - 当前线程等待时间超过了 n 毫秒,或t 线程运行结束,或调用了当前线程的

interrupt()时,当前线程从TIMED_WAITING --> RUNNABLE

7️⃣ RUNNABLE <--> TIMED_WAITING

- 当前线程调用

Thread.sleep(long n),当前线程从RUNNABLE --> TIMED_WAITING - 当前线程等待时间超过了 n 毫秒,当前线程从

TIMED_WAITING --> RUNNABLE

8️⃣ RUNNABLE <--> TIMED_WAITING

- 当前线程调用

LockSupport.parkNanos(long nanos)或LockSupport.parkUntil(long millis)时,当前线程从RUNNABLE --> TIMED_WAITING - 调用

LockSupport.unpark(目标线程)或调用了线程的interrupt(),或是等待超时,会让目标线程从TIMED_WAITING--> RUNNABLE

9️⃣ RUNNABLE <--> BLOCKED

- t 线程用

synchronized(obj)获取了对象锁时如果竞争失败,从RUNNABLE --> BLOCKED - 持 obj 锁线程的同步代码块执行完毕,会唤醒该对象上所有

BLOCKED的线程重新竞争,如果其中 t 线程竞争 成功,从BLOCKED --> RUNNABLE,其它失败的线程仍然BLOCKED

🔟 RUNNABLE <--> TERMINATED

- 当前线程所有代码运行完毕,进入

TERMINATED

3.11 多把锁

多把不相干的锁

一间大屋子有两个功能:睡觉、学习,互不相干。

现在小南要学习,小女要睡觉,但如果只用一间屋子(一个对象锁)的话,那么并发度很低

解决方法是准备多个房间(多个对象锁)

例如

1 | public class BigRoom { |

执行

1 | public static void main(String[] args) { |

结果

21:55:12.212 [小南] INFO com.lxd.juc.BigRoom -- study 1 小时 21:55:12.214 [小女] INFO com.lxd.juc.BigRoom -- sleeping 2 小时

改进

1 |

|

某次执行结果

21:56:01.214 [小南] INFO com.lxd.juc.BigRoom -- study 1 小时 21:56:01.214 [小女] INFO com.lxd.juc.BigRoom -- sleeping 2 小时

将锁的粒度细分

- 好处,是可以增强并发度

- 坏处,如果一个线程需要同时获得多把锁,就容易发生死锁

- 前提:两把锁锁住的两段代码互不相关

3.12 活跃性

3.12.1 死锁

多个线程同时被阻塞,它们中的一个或者全部都在等待某个资源被释放,由于线程被无限期地阻塞,因此程序不可能正常终止

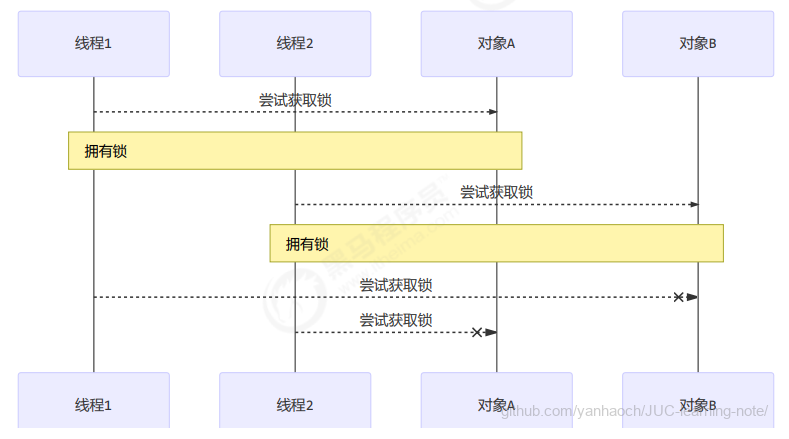

例:t1线程获得A对象锁,接下来想获取B对象的锁;t2线程获得B对象锁,接下来想获取A对象的锁

1 |

|

结果

22:02:52.854 [t1] INFO com.lxd.juc.DeadLock -- lock A 22:02:52.854 [t2] INFO com.lxd.juc.DeadLock -- lock B

定位死锁

检测死锁可以使用 jconsole工具,或者使用 jps 定位进程 id,再用 jstack 定位死锁:

1 | cmd > jps |

1 | cmd > jstack 33200 |

- 避免死锁要注意加锁顺序

- 另外如果由于某个线程进入了死循环,导致其它线程一直等待,对于这种情况 linux 下可以通过 top 先定位到 CPU 占用高的 Java 进程,再利用 top -Hp 进程id 来定位是哪个线程,最后再用 jstack 排查

Java 死锁产生的四个必要条件

- 互斥条件,即当资源被一个线程使用(占有)时,别的线程不能使用

- 占有且等待,即当资源请求者在请求其他的资源的同时保持对原有资源的占有

- 不可剥夺条件,资源请求者不能强制从资源占有者手中夺取资源,资源只能由资源占有者主动释放

- 循环等待条件,若干进程之间形成一种头尾相接的循环等待资源关系

四个条件都成立的时候,便形成死锁。死锁情况下打破上述任何一个条件,便可让死锁消失

3.12.2 活锁

活锁出现在两个线程互相改变对方的结束条件,最后谁也无法结束,例如

1 | public class TestLiveLock { |

解决方式:

- 错开线程的运行时间,使得一方不能改变另一方的结束条件。

- 将睡眠时间调整为随机数。

3.12.3 饥饿

很多教程中把饥饿定义为,一个线程由于优先级太低,始终得不到 CPU 调度执行,也不能够结束,饥饿的情况不易演示,讲读写锁时会涉及饥饿问题

下面我讲一下我遇到的一个线程饥饿的例子,先来看看使用顺序加锁的方式解决之前的死锁问题

顺序加锁的解决方案

说明:

- 顺序加锁可以解决死锁问题,但也会导致一些线程一直得不到锁,产生饥饿现象。

3.13 ReentrantLock

Synchronized 和 ReentrantLock 都是用于线程的同步控制,二者都是可重入锁

- Synchronized是Java内置特性,而ReentrantLock是通过Java代码实现的

- Synchronized是自动获取/释放锁,而ReentrantLock需要手动获取/释放锁

- ReentrantLock还具有响应中断、超时等待,支持多个条件变量等特性

- ReentrantLock可实现公平/非公平锁,而Synchronized只是非公平锁

3.13.1 基本语法

1 | // 获取锁 |

3.13.2 可重入

可重入是指同一个线程如果首次获得了这把锁,那么因为它是这把锁的拥有者,因此有权利再次获取这把锁 如果是不可重入锁,那么第二次获得锁时,自己也会被锁挡住。

1 | static ReentrantLock lock = new ReentrantLock(); |

输出

23:06:14.348 [main] INFO com.lxd.juc.TestReentrantLock -- execute method1 23:06:14.349 [main] INFO com.lxd.juc.TestReentrantLock -- execute method2 23:06:14.349 [main] INFO com.lxd.juc.TestReentrantLock -- execute method3

ReentrantLock如何实现可重入的

ReentrantLock 加锁时,会判断当前持有锁的线程和请求的线程是否是同一个,一样就可以重入。只需要将state值+1,记录当前线程的重入次数即可

1 | if(current==getExclusiveOwnerThread()){ |

同时,在锁进行释放的时候,需要确保state=0的时候才能执行释放资源的动作,也就是说,一个可重入锁,重入了多少次,就要解锁多少次

1 | protected final boolean tryRelease(int releases){ |

3.13.3 可打断

可打断指的是处于阻塞状态等待锁的线程可以被打断等待。注意lock.lockInterruptibly()和lock.trylock()方法是可打断的,lock.lock()不是。可打断的意义在于避免得不到锁的线程无限制地等待下去,防止死锁的一种方式。

1 | public static void main(String[] args) throws InterruptedException { |

输出

23:10:50.957 [main] INFO com.lxd.juc.TestReentrantLock -- 获得了锁 23:10:50.958 [t1] INFO com.lxd.juc.TestReentrantLock -- 启动... 23:10:50.959 [main] INFO com.lxd.juc.TestReentrantLock -- 执行打断 23:10:50.960 [t1] INFO com.lxd.juc.TestReentrantLock -- 等锁的过程中被打断 java.lang.InterruptedException at java.base/java.util.concurrent.locks.AbstractQueuedSynchronizer.acquireInterruptibly(AbstractQueuedSynchronizer.java:959) at java.base/java.util.concurrent.locks.ReentrantLock$Sync.lockInterruptibly(ReentrantLock.java:161) at java.base/java.util.concurrent.locks.ReentrantLock.lockInterruptibly(ReentrantLock.java:372) at com.lxd.juc.TestReentrantLock.lambda$main$0(TestReentrantLock.java:16) at java.base/java.lang.Thread.run(Thread.java:840)

注意lock()是不可中断模式,即使使用了 interrupt ,lock()也会忽略异常继续等待获取锁

1 |

|

输出

23:12:22.818 [main] INFO com.lxd.juc.TestReentrantLock -- 获得了锁 23:12:22.819 [t1] INFO com.lxd.juc.TestReentrantLock -- 启动... 23:12:22.820 [main] INFO com.lxd.juc.TestReentrantLock -- 执行打断 23:12:22.820 [t1] INFO com.lxd.juc.TestReentrantLock -- 获得了锁

3.13.4 锁超时

立即失败

1 |

|

输出

23:17:53.708 [main] INFO com.lxd.juc.TestReentrantLock -- 获得了锁 23:17:53.709 [t1] INFO com.lxd.juc.TestReentrantLock -- 启动... 23:17:53.709 [t1] INFO com.lxd.juc.TestReentrantLock -- 获取立刻失败,返回

超时失败

1 |

|

输出

23:22:51.849 [main] INFO com.lxd.juc.TestReentrantLock -- 获得了锁 23:22:51.850 [t1] INFO com.lxd.juc.TestReentrantLock -- 启动... 23:22:52.851 [t1] INFO com.lxd.juc.TestReentrantLock -- 获取等待 1s 后失败,返回

使用 tryLock 解决哲学家就餐问题

1 | class Chopstick extends ReentrantLock { |

1 | class Philosopher extends Thread { |

3.13.5 公平锁

ReentrantLock 默认是不公平的

1 |

|

强行插入,有机会在中间输出

t39 running... t40 running... t41 running... t42 running... t43 running... 强行插入 start... 强行插入 running... t44 running... t45 running... t46 running... t47 running... t49 running...

改为公平锁后

1 | ReentrantLock lock = new ReentrantLock(true); |

强行插入,总是在最后输出

t465 running... t464 running... t477 running... t442 running... t468 running... t493 running... t482 running... t485 running... t481 running... 强行插入 running...

公平锁一般没有必要,会降低并发度,后面分析原理时会讲解

3.13.6 条件变量

synchronized 中也有条件变量,就是我们讲原理时那个 waitSet 休息室,当条件不满足时进入 waitSet 等待

ReentrantLock 的条件变量比 synchronized 强大之处在于,它是支持多个条件变量的,这就好比

- synchronized 是那些不满足条件的线程都在一间休息室等消息

- 而 ReentrantLock 支持多间休息室,有专门等烟的休息室、专门等早餐的休息室、唤醒时也是按休息室来唤醒

使用要点

- await 前需要获得锁

- await 执行后,会释放锁,进入 conditionObject 等待

- await 的线程被唤醒(或打断、或超时)取重新竞争 lock 锁

- 竞争 lock 锁成功后,从 await 后继续执行

详细API

1 | public interface Condition { |

例子:

1 |

|

输出

23:36:46.238 [main] INFO com.lxd.juc.TestReentrantLock -- 送外卖来了 23:36:46.238 [Thread-1] INFO com.lxd.juc.TestReentrantLock -- 外卖来喽,开吃 23:36:46.240 [main] INFO com.lxd.juc.TestReentrantLock -- 送烟来了 23:36:46.240 [Thread-0] INFO com.lxd.juc.TestReentrantLock -- 烟来喽,干活

*同步模式之顺序控制

固定运行顺序

比如,必须先 2 后 1 打印

wait-notify版

1 |

|

可以看到,实现上很麻烦:

- 首先,需要保证先 wait 再 notify,否则 wait 线程永远得不到唤醒。因此使用了『运行标记』来判断该不该 wait

- 第二,如果有些干扰线程错误地 notify 了 wait 线程,条件不满足时还要重新等待,使用了 while 循环来解决 此问题

- 最后,唤醒对象上的 wait 线程需要使用 notifyAll,因为『同步对象』上的等待线程可能不止一个

await-signal版

1 |

|

Park Unpark 版

1 | public static void main(String[] args) { |

park 和 unpark 方法比较灵活,他俩谁先调用,谁后调用无所谓。并且是以线程为单位进行『暂停』和『恢复』, 不需要『同步对象』和『运行标记』

交替输出

线程 1 输出 a 5 次,线程 2 输出 b 5 次,线程 3 输出 c 5 次。现在要求输出 abcabcabcabcabc 怎么实现

wait-notify版

1 |

|

Lock 条件变量版

1 |

|

Park Unpark 版

1 |

|

4. 共享模型之内存

4.1 Java内存模型

Java 内存模型是 Java Memory Model(JMM),本身是一种抽象的概念,实际上并不存在,描述的是一组规则或规范,通过这组规范定义了程序中各个变量(包括实例字段,静态字段和构成数组对象的元素)的访问方式

JMM的意义:

- 规定了线程和内存之间的一些关系

- 屏蔽各种硬件和操作系统的内存访问差异,实现让 Java 程序在各种平台下都能达到一致的内存访问效果

- 计算机硬件底层的内存结构过于复杂,JMM的意义在于避免程序员直接管理计算机底层内存,用一些关键字synchronized、volatile等可以方便的管理内存。

JMM 体现在以下几个方面

- 原子性 - 保证指令不会受到线程上下文切换的影响

- 可见性 - 保证指令不会受 cpu 缓存的影响

- 有序性 - 保证指令不会受 cpu 指令并行优化的影响

根据 JMM 的设计,系统存在一个主内存(Main Memory),Java 中所有变量都存储在主存中,对于所有线程都是共享的;每条线程都有自己的工作内存(Working Memory),工作内存中保存的是主存中某些变量的拷贝,线程对所有变量的操作都是先对变量进行拷贝,然后在工作内存中进行,不能直接操作主内存中的变量;线程之间无法相互直接访问,线程间的通信(传递)必须通过主内存来完成

主内存和工作内存:

- 主内存:所有线程共享的内存区域,存储所有实例字段、静态字段和构成数组对象的元素

- 工作内存:每个线程私有的内存空间,存储该线程使用到的变量的主内存副本

JVM 和 JMM 之间的关系:JMM 中的主内存、工作内存与 JVM 中的 Java 堆、栈、方法区等并不是同一个层次的内存划分,这两者基本上是没有关系的,如果两者一定要勉强对应起来:

- 主内存主要对应于 Java 堆中的对象实例数据部分,而工作内存则对应于虚拟机栈中的部分区域

- 从更低层次上说,主内存直接对应于物理硬件的内存,工作内存对应寄存器和高速缓存

内存交互

Java 内存模型定义了 8 个操作来完成主内存和工作内存的交互操作,每个操作都是原子的

非原子协定:没有被 volatile 修饰的 long、double 外,默认按照两次 32 位的操作

- lock(锁定):作用于主内存,将一个变量标识为线程独占状态(对应 monitorenter)

- unclock(解锁):作用于主内存,将一个变量从独占状态释放出来,释放后的变量才可以被其他线程锁定(对应 monitorexit)

- read(读取):作用于主内存,把一个变量的值从主内存传输到工作内存中

- load(载入):作用于工作内存,在 read 之后执行,把 read 得到的值放入工作内存的变量副本中

- use(使用):作用于工作内存,把工作内存中一个变量的值传递给执行引擎,每当遇到一个使用到变量的操作时都要使用该指令

- assign(赋值):作用于工作内存,把从执行引擎接收到的一个值赋给工作内存的变量

- store(存储):作用于工作内存,把工作内存的一个变量的值传送到主内存中

- write(写入):作用于主内存,在 store 之后执行,把 store 得到的值放入主内存的变量中

参考文章:https://github.com/CyC2018/CS-Notes/blob/master/notes/Java 并发.md

4.2 原子性

原子性:不可分割,完整性,也就是说某个线程正在做某个具体业务时,中间不可以被分割,需要具体完成,要么同时成功,要么同时失败,保证指令不会受到线程上下文切换的影响

定义原子操作的使用规则:

- 不允许 read 和 load、store 和 write 操作之一单独出现,必须顺序执行,但是不要求连续

- 不允许一个线程丢弃 assign 操作,必须同步回主存

- 不允许一个线程无原因地(没有发生过任何 assign 操作)把数据从工作内存同步会主内存中

- 一个新的变量只能在主内存中诞生,不允许在工作内存中直接使用一个未被初始化(assign 或者 load)的变量,即对一个变量实施 use 和 store 操作之前,必须先执行 assign 和 load 操作

- 一个变量在同一时刻只允许一条线程对其进行 lock 操作,但 lock 操作可以被同一线程重复执行多次,多次执行 lock 后,只有执行相同次数的 unlock 操作,变量才会被解锁,lock 和 unlock 必须成对出现

- 如果对一个变量执行 lock 操作,将会清空工作内存中此变量的值,在执行引擎使用这个变量之前需要重新从主存加载

- 如果一个变量事先没有被 lock 操作锁定,则不允许执行 unlock 操作,也不允许去 unlock 一个被其他线程锁定的变量

- 对一个变量执行 unlock 操作之前,必须先把此变量同步到主内存中(执行 store 和 write 操作)

4.3 可见性

可见性:是指当多个线程访问同一个变量时,一个线程修改了这个变量的值,其他线程能够立即看得到修改的值

存在不可见问题的根本原因是由于缓存的存在,线程持有的是共享变量的副本,无法感知其他线程对于共享变量的更改,导致读取的值不是最新的。但是 final 修饰的变量是不可变的,就算有缓存,也不会存在不可见的问题

main 线程对 run 变量的修改对于 t 线程不可见,导致了 t 线程无法停止:

1 | static boolean run = true; //添加volatile |

原因:

- 初始状态, t 线程刚开始从主内存读取了 run 的值到工作内存

- 因为 t 线程要频繁从主内存中读取 run 的值,JIT 编译器会将 run 的值缓存至自己工作内存中的高速缓存中,减少对主存中 run 的访问,提高效率

- 1 秒之后,main 线程修改了 run 的值,并同步至主存,而 t 是从自己工作内存中的高速缓存中读取这个变量的值,结果永远是旧值

解决方法

volatile(易变关键字)

它可以用来修饰成员变量和静态成员变量,他可以避免线程从自己的工作缓存中查找变量的值,必须到主存中获取它的值,线程操作 volatile 变量都是直接操作主存

volatile 适合一个线程写,其他线程读的情况

可见性 vs 原子性

前面例子体现的实际就是可见性,它保证的是在多个线程之间,一个线程对 volatile 变量的修改对另一个线程可见, 不能保证原子性,仅用在一个写线程,多个读线程的情况: 上例从字节码理解是这样的:

getstatic run // 线程 t 获取 run true getstatic run // 线程 t 获取 run true getstatic run // 线程 t 获取 run true getstatic run // 线程 t 获取 run true putstatic run // 线程 main 修改 run 为 false, 仅此一次 getstatic run // 线程 t 获取 run false

比较一下之前我们将线程安全时举的例子:两个线程一个 i++ 一个 i-- ,只能保证看到最新值,不能解决指令交错

// 假设i的初始值为0 getstatic i // 线程2-获取静态变量i的值 线程内i=0 getstatic i // 线程1-获取静态变量i的值 线程内i=0 iconst_1 // 线程1-准备常量1 iadd // 线程1-自增 线程内i=1 putstatic i // 线程1-将修改后的值存入静态变量i 静态变量i=1 iconst_1 // 线程2-准备常量1 isub // 线程2-自减 线程内i=-1 putstatic i // 线程2-将修改后的值存入静态变量i 静态变量i=-1

注意

synchronized 语句块既可以保证代码块的原子性,也同时保证代码块内变量的可见性。但缺点是 synchronized 是属于重量级操作,性能相对更低 。

JMM关于synchronized的两条规定:

1)线程解锁前,必须把共享变量的最新值刷新到主内存中

2)线程加锁时,将清空工作内存中共享变量的值,从而使用共享变量时需要从主内存中重新获取最新的值

(注意:加锁与解锁需要是同一把锁)

通过以上两点,可以看到synchronized能够实现可见性。同时,由于synchronized具有同步锁,所以它也具有原子性

如果在前面示例的死循环中加入 System.out.println() 会发现即使不加 volatile 修饰符,线程 t 也能正确看到 对 run 变量的修改了,想一想为什么?(println方法中有synchronized代码块保证了可见性)

synchronized关键字不能阻止指令重排,但在一定程度上能保证有序性(如果共享变量没有逃逸出同步代码块的话)。因为在单线程的情况下指令重排不影响结果,相当于保障了有序性。

*模式之Balking

Balking (犹豫)模式用在一个线程发现另一个线程或本线程已经做了某一件相同的事,那么本线程就无需再做了,直接结束返回

1 | public class MonitorService { |

当前端页面多次点击按钮调用 start 时

输出

[http-nio-8080-exec-1] cn.itcast.monitor.service.MonitorService - 该监控线程已启动?(false) [http-nio-8080-exec-1] cn.itcast.monitor.service.MonitorService - 监控线程已启动... [http-nio-8080-exec-2] cn.itcast.monitor.service.MonitorService - 该监控线程已启动?(true) [http-nio-8080-exec-3] cn.itcast.monitor.service.MonitorService - 该监控线程已启动?(true) [http-nio-8080-exec-4] cn.itcast.monitor.service.MonitorService - 该监控线程已启动?(true)

为什么需要加锁?

- 当 t1 线程进入 start() 准备修改 initialized 状态,t2 线程进来,initialized 还为false,则 t2 就又执行一次

它还经常用来实现线程安全的单例

1 | public final class Singleton { |

对比保护性暂停模式:保护性暂停模式用在一个线程等待另一个线程的执行结果,当条件不满足时线程等待

4.4 有序性

JVM 会在不影响正确性的前提下,可以调整语句的执行顺序,思考下面一段代码

1 | static int i; |

可以看到,至于是先执行 i 还是 先执行 j ,对最终的结果不会产生影响。所以,上面代码真正执行时,既可以是

1 | i = ...; |

也可以是

1 | j = ...; |

这种特性称之为『指令重排』,多线程下『指令重排』会影响正确性。为什么要有重排指令这项优化呢?从 CPU 执行指令的原理来理解一下吧

*原理之指令级并行

Clock Cycle Time

主频的概念大家接触的比较多,而 CPU 的 Clock Cycle Time(时钟周期时间),等于主频的倒数,意思是 CPU 能 够识别的最小时间单位,比如说 4G 主频的 CPU 的 Clock Cycle Time 就是 0.25 ns,作为对比,我们墙上挂钟的 Cycle Time 是 1s

例如,运行一条加法指令一般需要一个时钟周期时间

CPI

有的指令需要更多的时钟周期时间,所以引出了 CPI (Cycles Per Instruction)指令平均时钟周期数

IPC

IPC(Instruction Per Clock Cycle) 即 CPI 的倒数,表示每个时钟周期能够运行的指令数

CPU 执行时间

程序的 CPU 执行时间,即我们前面提到的 user + system 时间,可以用下面的公式来表示

程序 CPU 执行时间 = 指令数 * CPI * Clock Cycle Time

指令重排序优化

事实上,现代处理器会设计为一个时钟周期完成一条执行时间最长的 CPU 指令。为什么这么做呢?可以想到指令 还可以再划分成一个个更小的阶段,例如,每条指令都可以分为: 取指令 - 指令译码 - 执行指令 - 内存访问 - 数据写回 这 5 个阶段

在不改变程序结果的前提下,这些指令的各个阶段可以通过重排序和组合来实现指令级并行,这一技术在 80’s 中 叶到 90’s 中叶占据了计算架构的重要地位。

指令重排的前提是,重排指令不能影响结果,例如

1 | // 可以重排的例子 |

参考:

Scoreboarding and the Tomasulo algorithm (which is similar to scoreboarding but makes use of register renaming )are two of the most common techniques for implementing out-of-order execution and instruction-level parallelism.

支持流水线的处理器

现代 CPU 支持多级指令流水线,例如支持同时执行 取指令 - 指令译码 - 执行指令 - 内存访问 - 数据写回 的处理器,就可以称之为五级指令流水线。这时 CPU 可以在一个时钟周期内,同时运行五条指令的不同阶段(相当于一 条执行时间最长的复杂指令),IPC = 1,本质上,流水线技术并不能缩短单条指令的执行时间,但它变相地提高了指令的吞吐率。

SuperScalar 处理器

大多数处理器包含多个执行单元,并不是所有计算功能都集中在一起,可以再细分为整数运算单元、浮点数运算单元等,这样可以把多条指令也可以做到并行获取、译码等,CPU 可以在一个时钟周期内,执行多于一条指令,IPC > 1

诡异的结果

1 | int num = 0; |

I_Result 是一个对象,有一个属性 r1 用来保存结果,问,可能的结果有几种?

有同学这么分析

情况1:线程1 先执行,这时 ready = false,所以进入 else 分支结果为 1

情况2:线程2 先执行 num = 2,但没来得及执行 ready = true,线程1 执行,还是进入 else 分支,结果为1

情况3:线程2 执行到 ready = true,线程1 执行,这回进入 if 分支,结果为 4(因为 num 已经执行过了)

但我告诉你,结果还有可能是 0 😁😁😁,信不信吧!

这种情况下是:线程2 执行 ready = true,切换到线程1,进入 if 分支,相加为 0,再切回线程2 执行 num = 2

相信很多人已经晕了 😵😵😵

这种现象叫做指令重排,是 JIT 编译器在运行时的一些优化,这个现象需要通过大量测试才能复现:

借助 java 并发压测工具 jcstress https://wiki.openjdk.java.net/display/CodeTools/jcstress

mvn archetype:generate -DinteractiveMode=false -DarchetypeGroupId=org.openjdk.jcstress - DarchetypeArtifactId=jcstress-java-test-archetype -DarchetypeVersion=0.5 -DgroupId=cn.itcast - DartifactId=ordering -Dversion=1.0

创建 maven 项目,提供如下测试类

1 |

|

执行

mvn clean install java -jar target/jcstress.jar

会输出我们感兴趣的结果,摘录其中一次结果:

*** INTERESTING tests

Some interesting behaviors observed. This is for the plain curiosity.

==== ==== ==== ==== ==== ==== ==== ==== ==== ==== ==== ==== ==== ====

2 matching test results.

[OK] test.ConcurrencyTest

(JVM args: [-XX:-TieredCompilation])

Observed state Occurrences Expectation Interpretation

0 1,729 ACCEPTABLE_INTERESTING !!!!

1 42,617,915 ACCEPTABLE ok

4 5,146,627 ACCEPTABLE ok

==== ==== ==== ==== ==== ==== ==== ==== ==== ==== ==== ==== ==== ====

[OK] test.ConcurrencyTest

(JVM args: [])

Observed state Occurrences Expectation Interpretation

0 1,652 ACCEPTABLE_INTERESTING !!!!

1 46,460,657 ACCEPTABLE ok

4 4,571,072 ACCEPTABLE ok

可以看到,出现结果为 0 的情况,虽然次数相对很少,但毕竟是出现了。

解决方法

volatile 修饰的变量,可以禁用指令重排

1 |

|

结果为:

*** INTERESTING tests Some interesting behaviors observed. This is for the plain curiosity. 0 matching test results.

4.5 volatile

4.5.1 同步机制

volatile 是 Java 虚拟机提供的轻量级的同步机制(三大特性)

- 保证可见性

- 不保证原子性

- 保证有序性(禁止指令重排)

性能:volatile 修饰的变量进行读操作与普通变量几乎没什么差别,但是写操作相对慢一些,因为需要在本地代码中插入很多内存屏障来保证指令不会发生乱序执行,但是开销比锁要小

synchronized 无法禁止指令重排和处理器优化,为什么可以保证有序性可见性

- 加了锁之后,只能有一个线程获得到了锁,获得不到锁的线程就要阻塞,所以同一时间只有一个线程执行,相当于单线程,由于数据依赖性的存在,单线程的指令重排是没有问题的

- 线程加锁前,将清空工作内存中共享变量的值,使用共享变量时需要从主内存中重新读取最新的值;线程解锁前,必须把共享变量的最新值刷新到主内存中(JMM 内存交互章节有讲)

4.5.2 指令重排

volatile 修饰的变量,可以禁用指令重排

指令重排实例:

1 | public void mySort() { |

执行顺序是:1 2 3 4、2 1 3 4、1 3 2 4

指令重排也有限制不会出现:4321,语句 4 需要依赖于 y 以及 x 的申明,因为存在数据依赖,无法首先执行

1 | int num = 0; |

情况一:线程 1 先执行,ready = false,结果为 r.r1 = 1

情况二:线程 2 先执行 num = 2,但还没执行 ready = true,线程 1 执行,结果为 r.r1 = 1

情况三:线程 2 先执行 ready = true,线程 1 执行,进入 if 分支结果为 r.r1 = 4

情况四:线程 2 执行 ready = true,切换到线程 1,进入 if 分支为 r.r1 = 0,再切回线程 2 执行 num = 2,发生指令重排

4.5.3 底层原理

缓存一致

使用 volatile 修饰的共享变量,底层通过汇编 lock 前缀指令进行缓存锁定,在线程修改完共享变量后写回主存,其他的 CPU 核心上运行的线程通过 CPU 总线嗅探机制会修改其共享变量为失效状态,读取时会重新从主内存中读取最新的数据

lock 前缀指令就相当于内存屏障,Memory Barrier(Memory Fence)

- 对 volatile 变量的写指令后会加入写屏障

- 对 volatile 变量的读指令前会加入读屏障

内存屏障有三个作用:

- 确保对内存的读-改-写操作原子执行

- 阻止屏障两侧的指令重排序

- 强制把缓存中的脏数据写回主内存,让缓存行中相应的数据失效

保证可见性

-

写屏障(sfence,Store Barrier)保证在该屏障之前的,对共享变量的改动,都同步到主存当中

1

2

3

4

5public void actor2(I_Result r) {

num = 2;

ready = true; // ready 是 volatile 赋值带写屏障

// 写屏障

} -

读屏障(lfence,Load Barrier)保证在该屏障之后的,对共享变量的读取,从主存刷新变量值,加载的是主存中最新数据

1

2

3

4

5

6

7

8

9public void actor1(I_Result r) {

// 读屏障

// ready 是 volatile 读取值带读屏障

if(ready) {

r.r1 = num + num;

} else {

r.r1 = 1;

}

}

-

全能屏障:mfence(modify/mix Barrier),兼具 sfence 和 lfence 的功能

保证有序性

-

写屏障会确保指令重排序时,不会将写屏障之前的代码排在写屏障之后

1

2

3

4

5public void actor2(I_Result r) {

num = 2;

ready = true; // ready 是 volatile 赋值带写屏障

// 写屏障

} -

读屏障会确保指令重排序时,不会将读屏障之后的代码排在读屏障之前

1

2

3

4

5

6

7

8

9public void actor1(I_Result r) {

// 读屏障

// ready 是 volatile 读取值带读屏障

if(ready) {

r.r1 = num + num;

} else {

r.r1 = 1;

}

}

不能解决指令交错

-

写屏障仅仅是保证之后的读能够读到最新的结果,但不能保证其他线程的读跑到写屏障之前

-

有序性的保证也只是保证了本线程内相关代码不被重排序

1

2

3volatile i = 0;

new Thread(() -> {i++});

new Thread(() -> {i--});i++ 反编译后的指令:

1

2

30: iconst_1 // 当int取值 -1~5 时,JVM采用iconst指令将常量压入栈中

1: istore_1 // 将操作数栈顶数据弹出,存入局部变量表的 slot 1

2: iinc 1, 1

对于 volatile 修饰的变量:

- 线程对变量的 use 与 load、read 操作是相关联的,所以变量使用前必须先从主存加载

- 线程对变量的 assign 与 store、write 操作是相关联的,所以变量使用后必须同步至主存

- 线程 1 和线程 2 谁先对变量执行 read 操作,就会先进行 write 操作,防止指令重排

4.5.4 双端检锁

double-checked locking 单例模式

1 | public final class Singleton { |

以上的实现特点是:

- 懒惰实例化

- 首次使用 getInstance() 才使用 synchronized 加锁,后续使用时无需加锁

- 有隐含的,但很关键的一点:第一个 if 使用了 INSTANCE 变量,是在同步块之外

但在多线程环境下,上面的代码是有问题的,getInstance 方法对应的字节码为:

0: getstatic #2 // Field INSTANCE:Lcn/itcast/n5/Singleton; 3: ifnonnull 37 6: ldc #3 // class cn/itcast/n5/Singleton 8: dup 9: astore_0 10: monitorenter 11: getstatic #2 // Field INSTANCE:Lcn/itcast/n5/Singleton; 14: ifnonnull 27 17: new #3 // class cn/itcast/n5/Singleton 20: dup 21: invokespecial #4 // Method "":()V 24: putstatic #2 // Field INSTANCE:Lcn/itcast/n5/Singleton; 27: aload_0 28: monitorexit 29: goto 37 32: astore_1 33: aload_0 34: monitorexit 35: aload_1 36: athrow 37: getstatic #2 // Field INSTANCE:Lcn/itcast/n5/Singleton; 40: areturn

其中

- 17 表示创建对象,将对象引用入栈 // new Singleton

- 20 表示复制一份对象引用 // 引用地址

- 21 表示利用一个对象引用,调用构造方法

- 24 表示利用一个对象引用,赋值给 static INSTANCE

也许 jvm 会优化为:先执行 24,再执行 21。如果两个线程 t1,t2 按如下时间序列执行:

关键在于 0: getstatic 这行代码在 monitor 控制之外,它就像之前举例中不守规则的人,可以越过 monitor 读取 INSTANCE 变量的值

这时 t1 还未完全将构造方法执行完毕,如果在构造方法中要执行很多初始化操作,那么 t2 拿到的是将是一个未初始化完毕的单例。

对 INSTANCE 使用 volatile 修饰即可,可以禁用指令重排,但要注意在 JDK 5 以上的版本的 volatile 才会真正有效

double-checked locking 解决

1 | public final class Singleton { |

字节码上看不出来 volatile 指令的效果

// -------------------------------------> 加入对 INSTANCE 变量的读屏障 0: getstatic #2 // Field INSTANCE:Lcn/itcast/n5/Singleton; 3: ifnonnull 37 6: ldc #3 // class cn/itcast/n5/Singleton 8: dup 9: astore_0 10: monitorenter -----------------------> 保证原子性、可见性 11: getstatic #2 // Field INSTANCE:Lcn/itcast/n5/Singleton; 14: ifnonnull 27 17: new #3 // class cn/itcast/n5/Singleton 20: dup 21: invokespecial #4 // Method "":()V 24: putstatic #2 // Field INSTANCE:Lcn/itcast/n5/Singleton; // -------------------------------------> 加入对 INSTANCE 变量的写屏障 27: aload_0 28: monitorexit ------------------------> 保证原子性、可见性 29: goto 37 32: astore_1 33: aload_0 34: monitorexit 35: aload_1 36: athrow 37: getstatic #2 // Field INSTANCE:Lcn/itcast/n5/Singleton; 40: areturn

如上面的注释内容所示,读写 volatile 变量时会加入内存屏障(Memory Barrier(Memory Fence)),保证下面 两点:

- 可见性

- 写屏障(sfence)保证在该屏障之前的 t1 对共享变量的改动,都同步到主存当中

- 而读屏障(lfence)保证在该屏障之后 t2 对共享变量的读取,加载的是主存中最新数据

- 有序性

- 写屏障会确保指令重排序时,不会将写屏障之前的代码排在写屏障之后

- 读屏障会确保指令重排序时,不会将读屏障之后的代码排在读屏障之前

- 更底层是读写变量时使用 lock 指令来多核 CPU 之间的可见性与有序性

4.5.5 happens-before

happens-before 规定了对共享变量的写操作对其它线程的读操作可见,它是可见性与有序性的一套规则总结,抛开以下 happens-before 规则,JMM 并不能保证一个线程对共享变量的写,对于其它线程对该共享变量的读可见

happends-before原则的适用场景

- 程序次序规则(ProgramOrderRule):在单个线程内,按照程序代码的顺序,前一个操作happens-before 后一个操作。

1 | public class ProgramOrderExample{ |

- 管程锁定规则(MonitorLockRule):对一个锁的解锁happens-before 随后对这个锁的加锁。即在 synchronized代码块或方法中,释放锁之前的所有操作对于下一个获取这个锁的线程是可见的。

1 | public class MonitorLockExample{ |

increment方法中对value的修改,在getValue方法获取锁之后是可见的。

- volatile变量规则(VolatileVariableRule): 对一个volatile字段的写操作happens-before任意后续对这 个字段的读操作。即确保volatile变量的写操作对其他线程立即可见

1 | public class VolatileExample{ |

当一个线程调用writeFlag(),另一个线程随后调用checkFlag()将看到flag为true。

- 线程启动规则(ThreadStartRule):对线程的start()方法的调用happens-before该线程的每个动作。确保线程启动时,主线程中对共享变量的写操作对于新线程是可见的。

1 | public class ThreadStartExample{ |

线程启动时,将看到startValue的值为11。

- 线程终止规则(ThreadTerminationRule):一个线程的所有操作happens-before对这个线程的join()方 法的成功返回。确保线程终止时,该线程中的所有操作对于调用join()方法的线程是可见的。

1 | public class ThreadJoinExample{ |

主线程中可以看到子线程对counter的修改

-

线程中断规则(ThreadInterruptionRule):对线程的interrupt()方法的调用happens-before被中断线程检测到中断事件的发生。即线程的中断操作在被该线程检测到之前已经发生。

-

对象终结规则(FinalizerRule):一个对象的初始化完成(构造函数执行结束)happens-before它的finalize()方法的开始。即在对象被回收前,其构造过程已经完全结束。

1 | public class FinalizerExample{ |

- 传递性(Transitivity):如果操作A先行发生于操作B,操作B先行发生于操作C,那就可以得出操作A先行发生于操作C的结论。

1 | public class TransitivityExample{ |

由于ready是一个volatile变量,写入ready(操作B)发生在读取ready之前,同样,写入number(操作A)发生在写入ready之前。根据传递性规则,写入number发生在读取ready之前。

参考链接:happens-before规则解析 - 知乎 (zhihu.com)

*单例模式的实现方法

饿汉、懒汉、静态内部类、枚举类,试分析每种实现下获取单例对象(即调用 getInstance)时的线程安全,并思考注释中的问题

饿汉式:类加载就会导致该单实例对象被创建

懒汉式:类加载不会导致该单实例对象被创建,而是首次使用该对象时才会创建

实现1(饿汉式):

1 | // 问题1:为什么加 final(防止被子类继承从而重写方法改写单例) |

实现2(枚举类):

1 | // 问题1:枚举单例是如何限制实例个数的 (枚举类会按照声明的个数在类加载时实例化对象) |

实现3(synchronized方法):

1 | public final class Singleton { |

实现4:DCL+volatile

1 | public final class Singleton { |

实现5(内部类初始化):

1 | public final class Singleton { |

5. 共享模型之无锁

5.1 问题提出(应用之互斥)

有如下需求,保证 account.withdraw 取款方法的线程安全

1 | interface Account { |

原有实现并不是线程安全的

1 | class AccountUnsafe implements Account { |

执行测试代码

1 | public static void main(String[] args) { |

某次的执行结果

330 cost: 306 ms

为什么不安全

1 | public void withdraw(Integer amount) { |

对应的字节码

ALOAD 0 ALOAD 0 GETFIELD cn/itcast/AccountUnsafe.balance : Ljava/lang/Integer; INVOKEVIRTUAL java/lang/Integer.intValue ()I ALOAD 1 INVOKEVIRTUAL java/lang/Integer.intValue ()I ISUB // 减法 INVOKESTATIC java/lang/Integer.valueOf (I)Ljava/lang/Integer; PUTFIELD cn/itcast/AccountUnsafe.balance : Ljava/lang/Integer;

| 字节码指令 | 栈状态变化 | 作用说明 |

|---|---|---|

ALOAD 0 |

[this] | 加载局部变量表第0槽位的this对象引用(当前AccountUnsafe实例) |

ALOAD 0 |

[this, this] | 再次加载this引用 |

GETFIELD balance |

[Integer] | 获取this.balance 字段值(Integer对象) |

INVOKEVIRTUAL intValue() |

[int] | 调用Integer.intValue() 拆箱为原始int值 |

ALOAD 1 |

[int, Integer] | 加载局部变量表第1槽位的amount参数(Integer对象) |

INVOKEVIRTUAL intValue() |

[int, int] | 拆箱amount为原始int值 |

ISUB |

[int] | 执行减法操作(栈顶两int值相减) |

INVOKESTATIC Integer.valueOf() |

[Integer] | 将减法结果装箱为Integer对象 |

PUTFIELD balance |

[] | 将新Integer对象存入this.balance 字段 |

- 多步骤非原子性

从读取balance到写入新值共经历 7步操作,若多个线程交叉执行,会导致:- 脏读:线程B在A计算期间读取到未更新的旧值

- 丢失更新:后写入的线程覆盖前一线程的结果(如

100-50-30可能得70而非正确值20)

- 拆箱/装箱的隐藏风险

Integer的不可变性导致每次运算都创建新对象,若并发PUTFIELD可能引发对象引用竞争- 自动装箱缓存问题(

-128~127)可能意外共享Integer实例

- 内存可见性缺失

- 无

volatile修饰时,balance字段更新可能对其他线程不可见(线程缓存未刷新)

- 无

5.1.1 解决思路-锁(悲观互斥)

首先想到的是给 Account 对象加锁

1 | class AccountUnsafe implements Account { |

结果为

0 cost: 399 ms

5.1.2 解决思路-无锁(乐观重试)

1 | class AccountSafe implements Account { |

执行测试代码

1 | public static void main(String[] args) { |

某次的执行结果

0 cost: 302 ms

5.2 CAS与volatile

前面看到的 AtomicInteger 的解决方法,内部并没有用锁来保护共享变量的线程安全。那么它是如何实现的呢?

1 | public void withdraw(Integer amount) { |

其中的关键是 compareAndSet,它的简称就是 CAS (也有 Compare And Swap 的说法),它必须是原子操作。

5.2.1 CAS

无锁编程:Lock Free

CAS 的全称是 Compare-And-Swap,是 CPU 并发原语

- CAS 并发原语体现在 Java 语言中就是 sun.misc.Unsafe 类的各个方法,调用 UnSafe 类中的 CAS 方法,JVM 会实现出 CAS 汇编指令,这是一种完全依赖于硬件的功能,实现了原子操作

- CAS 是一种系统原语,原语属于操作系统范畴,是由若干条指令组成 ,用于完成某个功能的一个过程,并且原语的执行必须是连续的,执行过程中不允许被中断,所以 CAS 是一条 CPU 的原子指令,不会造成数据不一致的问题,是线程安全的

底层原理:CAS 的底层是 lock cmpxchg 指令(X86 架构),在单核和多核 CPU 下都能够保证比较交换的原子性

-

程序是在单核处理器上运行,会省略 lock 前缀,单处理器自身会维护处理器内的顺序一致性,不需要 lock 前缀的内存屏障效果

-

程序是在多核处理器上运行,会为 cmpxchg 指令加上 lock 前缀。当某个核执行到带 lock 的指令时,CPU 会执行总线锁定或缓存锁定,将修改的变量写入到主存,这个过程不会被线程的调度机制所打断,保证了多个线程对内存操作的原子性

作用:比较当前工作内存中的值和主物理内存中的值,如果相同则执行规定操作,否则继续比较直到主内存和工作内存的值一致为止

CAS 特点:

- CAS 体现的是无锁并发、无阻塞并发,线程不会陷入阻塞,线程不需要频繁切换状态(上下文切换,系统调用)

- CAS 是基于乐观锁的思想

CAS 缺点:

- 执行的是循环操作,如果比较不成功一直在循环,最差的情况某个线程一直取到的值和预期值都不一样,就会无限循环导致饥饿,使用 CAS 线程数不要超过 CPU 的核心数,采用分段 CAS 和自动迁移机制

- 只能保证一个共享变量的原子操作

- 对于一个共享变量执行操作时,可以通过循环 CAS 的方式来保证原子操作

- 对于多个共享变量操作时,循环 CAS 就无法保证操作的原子性,这个时候只能用锁来保证原子性

- 引出来 ABA 问题

5.2.2 volatile

获取共享变量时,为了保证该变量的可见性,需要使用 volatile 修饰。

它可以用来修饰成员变量和静态成员变量, 避免线程从自己的工作缓存中查找变量的值,必须到主存中获取值,线程操作 volatile 变量都是直接操作主存。即一个线程对 volatile 变量的修改,对另一个线程可见。

CAS 必须借助 volatile 才能读取到共享变量的最新值来实现【比较并交换】的效果。

为什么无锁效率高

- 无锁情况下,即使重试失败,线程始终在高速运行,没有停歇,类似于自旋。而 synchronized 会让线程在没有获得锁的时候,发生上下文切换,进入阻塞。线程的上下文切换是费时的,在重试次数不是太多时,无锁的效率高于有锁。线程就好像高速跑道上的赛车,高速运行时,速度超快,一旦发生上下文切换,就好比赛车要减速、熄火, 等被唤醒又得重新打火、启动、加速… 恢复到高速运行,代价比较大

- 但无锁情况下,因为线程要保持运行,需要额外 CPU 的支持,CPU 在这里就好比高速跑道,没有额外的跑道,线程想高速运行也无从谈起,虽然不会进入阻塞,但由于没有分到时间片,仍然会进入可运行状态,还是会导致上下文切换。

- 所以总的来说,当线程数小于等于cpu核心数时,使用无锁方案是很合适的,因为有足够多的cpu让线程运行。当线程数远多于cpu核心数时,无锁效率相比于有锁就没有太大优势,因为依旧会发生上下文切换。

CAS 与 synchronized 总结

- synchronized 是从悲观的角度出发:总是假设最坏的情况,每次去拿数据的时候都认为别人会修改,所以每次在拿数据的时候都会上锁,这样别人想拿这个数据就会阻塞(共享资源每次只给一个线程使用,其它线程阻塞,用完后再把资源转让给其它线程),因此 synchronized 也称之为悲观锁,ReentrantLock 也是一种悲观锁,性能较差

- CAS 是从乐观的角度出发:总是假设最好的情况,每次去拿数据的时候都认为别人不会修改,所以不会上锁,但是在更新的时候会判断一下在此期间别人有没有去更新这个数据。如果别人修改过,则获取现在最新的值,如果别人没修改过,直接修改共享数据的值,CAS 这种机制也称之为乐观锁,综合性能较好

5.3 原子整数

常见原子类:AtomicInteger、AtomicBoolean、AtomicLong

以 AtomicInteger 为例,构造方法:

public AtomicInteger():初始化一个默认值为 0 的原子型 Integerpublic AtomicInteger(int initialValue):初始化一个指定值的原子型 Integer

常用API:

| 方法 | 作用 |

|---|---|

| public final int get() | 获取 AtomicInteger 的值 |